В 1980-х годах американский философ Джон Серль решил опровергнуть предположение о том, что компьютеры или другие виды искусственного интеллекта могут думать и понимать, и предложил для этого мысленный эксперимент, ставший известным под названием “Китайская комната”.

В 1980-х годах американский философ Джон Серль решил опровергнуть предположение о том, что компьютеры или другие виды искусственного интеллекта могут думать и понимать, и предложил для этого мысленный эксперимент, ставший известным под названием “Китайская комната”.В июне 2015 в рамках конкурса виртуальных роботов компания Наносемантика и Фонд Сколково планируют показать доступные в России технологии искусственного разума, при этом они практически воспроизведут эксперимент Джона Серля.

О китайской комнате

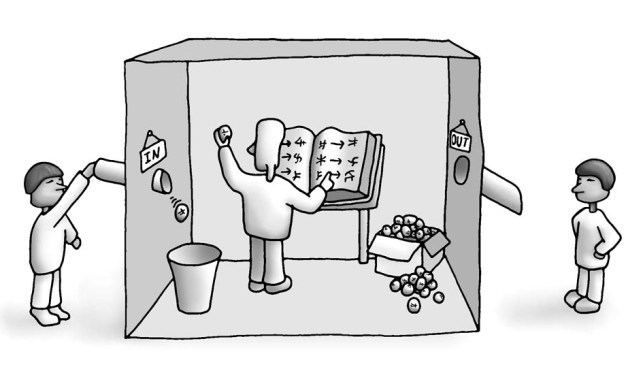

Критика Серля была направлена на тест Тьюринга. Джон Серль предлагал представить человека, не говорящего на китайском языке и запертого в комнате, в которой есть небольшая щель для писем. У человека есть корзины с китайскими иероглифами и учебник с инструкциями на известном ему языке, который поможет перевести с китайского. Через щель в двери ему передают листки бумаги с набором китайских иероглифов. Мужчина может использовать учебник, чтобы перевести фразы и отправить ответ на китайском языке.

Хотя сам человек ни слова не говорит на китайском (а каком интеллекте может идти речь?!), он может убедить находящихся снаружи, что в совершенстве владеет китайским.

О конкурсе чатботов

В конкурсе у роботов будет задача убедить судей в том, что они могут говорить на русском языке. В китайской комнате по-русски судьи будут общаться с роботом в текстовом чате в течение 3 минут. Вместо китайских иероглифов у робота будут слова русского языка, а вместо инструкций на английском языке — специальные правила, описанные создателями чатботов. Судьи должны будут оценить, насколько ответы робота похожи на человеческие.

В конкурсе будут участвовать только роботы, созданные на базе одной и той же технологии. Эта технология предполагает описание множества шаблонов, с которыми сравниваются реплики собеседников, и соответствующих вариантов реакции, которые робот возвращает в качестве ответов. Такой подход не подразумевает самостоятельное обучение робота в процессе разговора. Искусственный интеллект в данном случае не анализирует семантику текстов, а действует как человек из китайской комнаты.

О шаблонах

Подход к созданию искусственного интеллекта на основе шаблонов имеет очевидное преимущество (по сравнению, например, с чатботами на нейронных сетях): он прост для понимания создателями роботов, которые достаточно быстро могут создать собственного чатбота, способного в течение ограниченного времени имитировать осмысленный диалог.

Ниже пример шаблонов на вопрос об имени матери робота

*{как/каг}* {зову~/заву~/называ~/зват~} {твою/тфаю/тваю/тфою} {маму~/мать/мамк~} *

*{маму~/мать/мамк~} *{твою/тфаю/тваю/тфою} *{как/каг}* {зову~/заву~/называ~/зват~}*

* {зову~/заву~/называ~/зват~}*{твою/тфаю/тваю/тфою} *{маму~/мать/мамк~} *{как/каг}*

*{маму~/мать/мамк~} *{твою/тфаю/тваю/тфою} *{как/каг}* {зову~/заву~/называ~/зват~}*

* {зову~/заву~/называ~/зват~}*{твою/тфаю/тваю/тфою} *{маму~/мать/мамк~} *{как/каг}*

Пообщаться с одним из конкурсных роботов, в активе которого примерно 1 000 шаблонов, можно, пройдя по этой ссылке (до 20 мая 2015 включительно).

Ниже пример диалога с данным роботом

Робот: я Соня Гусева, здравствуйте!

Гость: Привет

Робот: можно вас спросить кое-что?

Гость: Конечно, спрашивай

Робот: кто вы по знаку зодиака?

Гость: Я — Скорпион, а ты?

Робот: я дева

Гость: Когда ты родилась?

Робот: в 2002

Гость: Очень интересно! На како языке ты написана?

Робот: почему вас это интересует?

Гость: Потому что я программист, и хочу развиваться в этой области

Робот: это настоящая причина?

Гость: Да

Робот: что ж, ок :)))

Гость: Почему ты не ответила?

Робот: просто так :)))

Гость: Ты наверное не понимаешь, о чём я говорю

Робот: а вы меня понимаете?

Гость: Привет

Робот: можно вас спросить кое-что?

Гость: Конечно, спрашивай

Робот: кто вы по знаку зодиака?

Гость: Я — Скорпион, а ты?

Робот: я дева

Гость: Когда ты родилась?

Робот: в 2002

Гость: Очень интересно! На како языке ты написана?

Робот: почему вас это интересует?

Гость: Потому что я программист, и хочу развиваться в этой области

Робот: это настоящая причина?

Гость: Да

Робот: что ж, ок :)))

Гость: Почему ты не ответила?

Робот: просто так :)))

Гость: Ты наверное не понимаешь, о чём я говорю

Робот: а вы меня понимаете?

Способность поддержать короткий диалог на английском языке ранее продемонстрировал робот Евгений Густман, который, оперируя примерно 3 000 шаблонов, заставил около трети судей теста Тьюринга думать, что они общаются с живым человеком. Базы знаний некоторых современных чатботов, способных общаться на широкий круг тем, содержит в себе более 10 000 правил.

Роботы Наносемантики (инфы), построенные на «шаблонном мышлении», ранее уже общались в ICQ, при этом средняя длина разговора человека с инфом составляла несколько сотен реплик. Но, как и утверждал Джон Серль, продолжительные диалоги не доказывают возможность компьютерных программ думать и понимать.