2016 год провозгласили началом эпохи Flash-накопителей: флеш становится дешевле и доступнее. А вслед за снижением стоимости ssd-накопителей производители выпускают массивы, логика которых изначально создана для работы только с быстрыми флешами. Стоимость таких решений все равно выводит их в корпоративный сегмент рынка, не позволяя небольшим компаниям познать все «прелести» ssd-эпохи. И вот, компания Synology сделала свой ход: встречайте бюджетный full-flash массив Synology FS3017. Что это – маркетинговый ход, или первый бюджетный флеш-массив?

Причины появления флеш-систем (All Flash Array – AFA) достаточно просты — унифицированные гибридные массивы не справляются с огромной производительностью флеш-накопителей, а логика работы основывается на взаимодействии с классическими HDD, увеличивая время отклика системы и износ SSD. Основываясь на этом, можно выделить 3 основных отличия AFA:

Именно поэтому, когда коллеги предложили мне протестировать массив Synology FS3017, я очень удивился. Давайте вместе оценим его параметры и определимся, подходит ли он под категорию AFA.

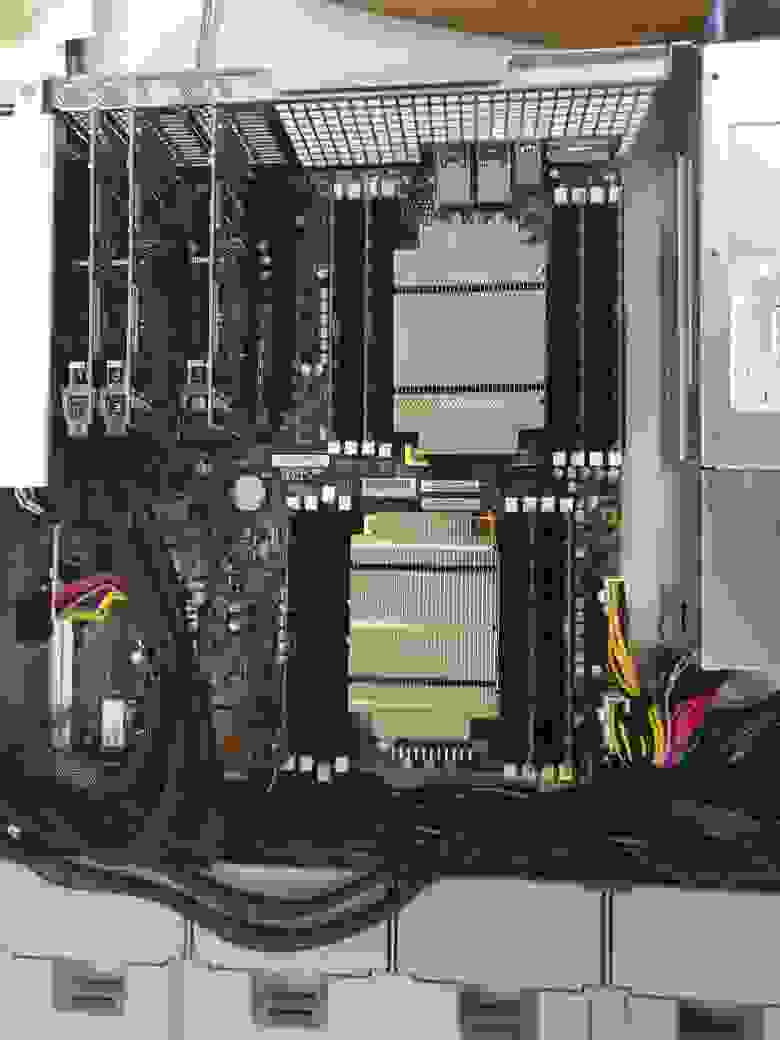

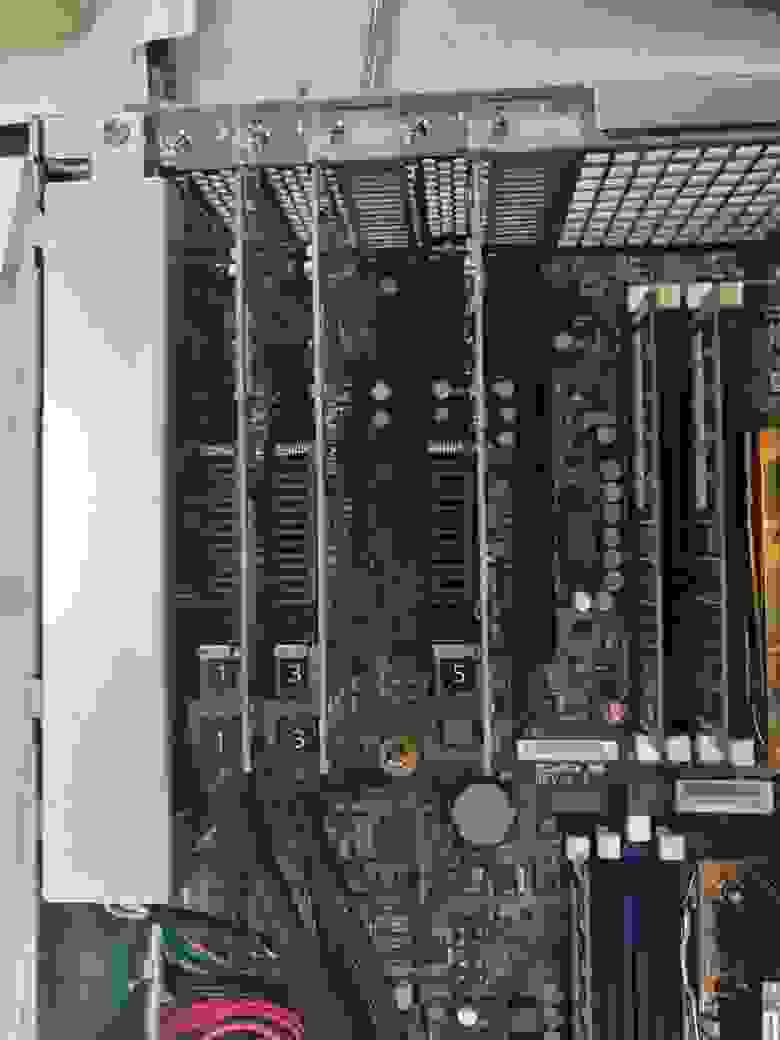

Массив FS3017 имеет стандартное стоечное исполнение: в корпусе высотой 2U помещается 24 SFF накопителя, поддерживаются накопители различных производителей (Intel, OCZ, Seagate и т.д.), что характерно для всей продукции Synology. Но что удивило меня больше всего — так это поддержка классических HDD — это ставит под вопрос принадлежность FS3017 к сегменту AFA. Из положительного — поддерживаются накопители как enterprise-класса с SAS-интерфейсом, так и более бюджетные SATA-накопители.

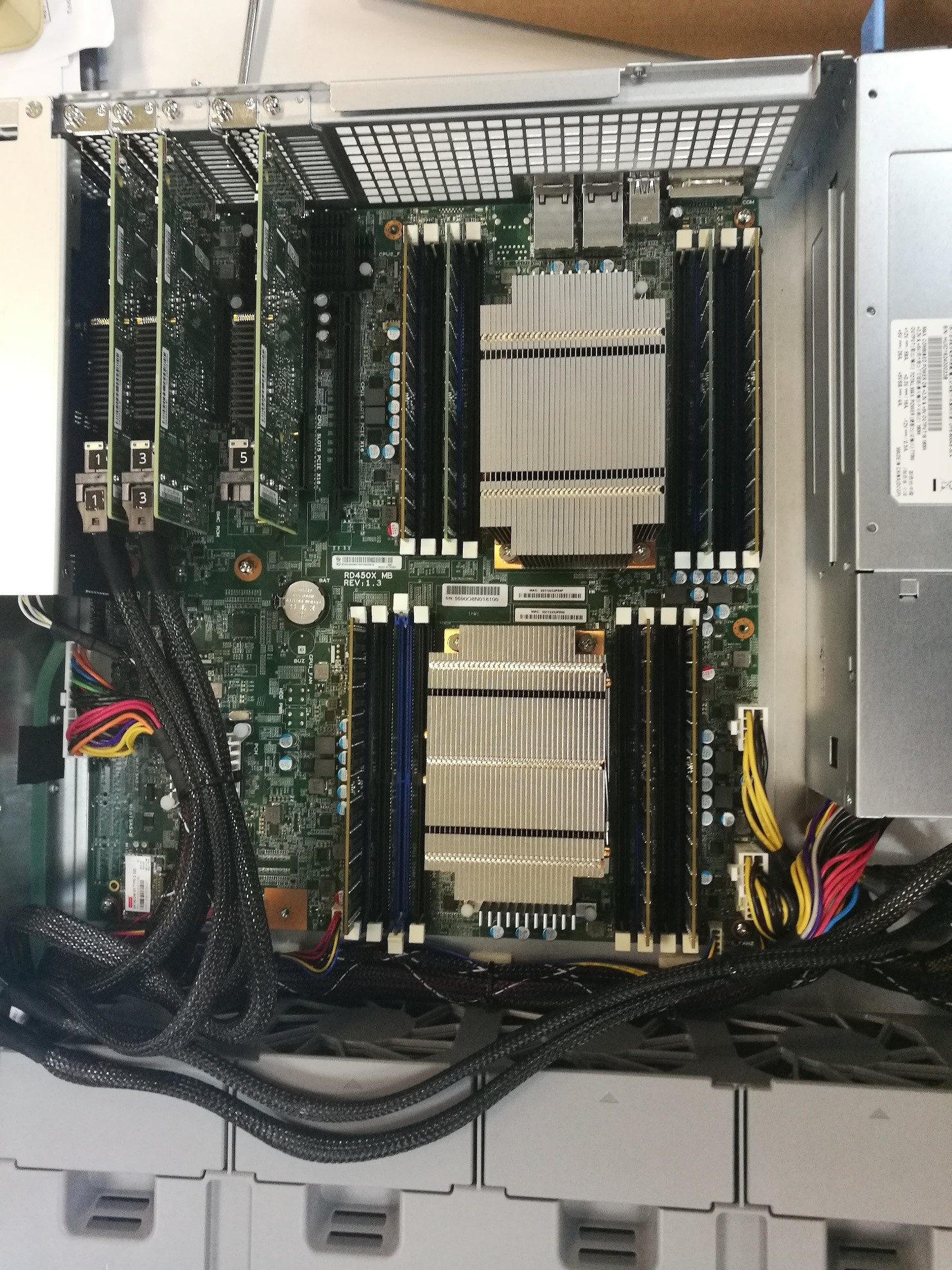

В качестве процессора используются 2 x Intel Xeon E5-2620 (6-core, 2.4 GHz) v3, объём встроенной памяти составляет 64GB DDR4, и может быть расширен до внушительных 512 Gb.

В качестве сетевых интерфейсов в базовой конфигурации имеются 2 порта 10 GE с поддержкой технологии Link Aggregation, используемых как для управления массивом, так и для передачи данных. Дополнительно можно установить 2 PCI-E (x16 и x8) модуля: сетевой модуль расширения (1GbE / 10GbE / 25GbE / 40GbE) или SAS-модуль для подключения двух дополнительных дисковых полок (RX1217sas на 12 LFF-слота или RX2417sas на 24 SFF-слота).

В качестве операционной системы используется знакомый всем пользователям Synology DiskStation Manager (DSM) версии 6.1. Я ожидал, что для своего AFA Synology выпустит особую версию микрокода, но она соответствует DSM настольных и стоечных моделей. Так что же делает этот массив AFA? Как выяснилось – поддержка технологии RAID F1.

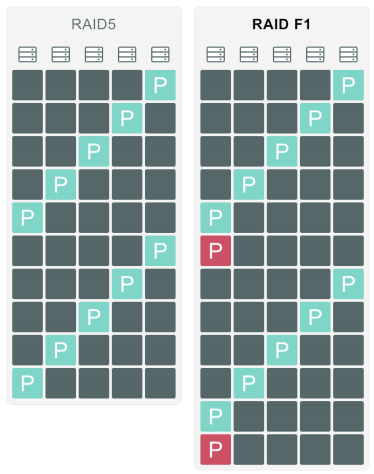

Согласно описанию производителя технология RAID F1 призвана снизить вероятность потери данных, связанной с выходом из строя всей RAID-группы целиком. Так как в отличие от HDD выход из строя SSD-накопителей обусловлен окончанием ресурса накопителя (износом ячеек), то, теоретически, возможна ситуация, когда все накопители одного рейда умрут одновременно. Во избежание такой ситуации был разработан RAID F1. Распределяя блоки данных между накопителями аналогично RAID 5, RAID F1 записывает блок с контрольными суммами дважды на 1 накопитель. Это приводит к тому, что его ресурс тратится быстрее, а значит вероятность выхода из строя всех дисков рейда уменьшается. После завершения ресурса и замены накопителя система автоматически выбирает наиболее изношенный накопитель, и начинает писать дублирующие блоки на него.

Несмотря на все заявления производителей, SSD до сих пор остаются дорогостоящими накопителями, и умышленно снижать их ресурс представляется не самым оправданным решением проблемы с точки зрения бизнеса. В то время как основные игроки AFA-рынка внедряют технологии балансировки и снижения объема записываемых данных для продления срока жизни ssd-накопителей, Synology пошли в противоположную сторону. Насколько оправдан и будет ли признан рынком такой подход покажет время.

В остальном массив FS отличается от линейки RS (стоечные массивы Synology) наличием более мощного процессора (Intel Xeon D Family), второго сокета и поддержки RAID F1. Унаследовал FS3017 и стандартные сценарии использования – список рекомендованных пакетов DSM состоит из сервера облачного хранилища, сервера заметок и видеорегистратора. Ни о какой оптимизации архитектуры и логики для использования ssd речи тут не идет, в пользу чего говорит и наличие функции SSD-кэша. Так как два из трех признаков AFA-систем не соблюдаются, остается проверить насколько массив может прокачивать наши ssd-накопители.

Систему для тестов мне предоставили с расширенной до 128 Gb памятью и 12-ю накопителями Intel SSD DC S3520 Series объемом 480 Gb. Достойные показатели производительности и доступная за счет использование SATA-интерфейса цена делают их наиболее интересными для тех, кто планирует собирать флеш-систему бюджетного класса. Я выделил 1 диск под горячую замену (поддерживается глобальная замена дисков со всех полок) и 11 дисков я объединил в RAID F1. На получившейся RAID-группе я создал iSCSI-том и презентовал его серверу под управлением Windows Server 2016. Спецификация сервера: 2*Intel Xeon E5-2695 V3 2.3 GHz 14-core, 128 Gb RAM, 2-port 10 GE Base-T. По техническим причинам мне пришлось использовать только один порт 10 GE Base-T, что явно сказалось на производительности массива.

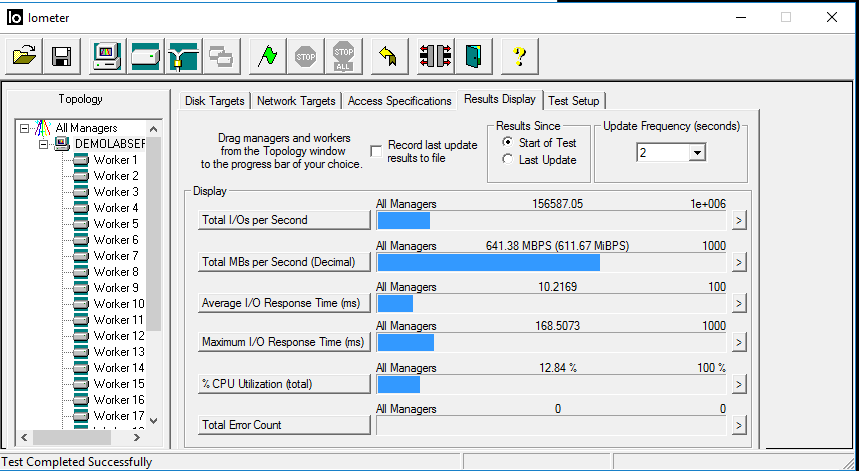

Нагрузку я генерировал самой популярной на рынке программой синтетических тестов Iometer. Целью тестов была не производительность дисков, а самого массива, поэтому я решил использовать паттерн 4KiB 100% random.

Начать я решил с «идеальной» нагрузки в 100% read, чтоб проверить посмотреть на «красивую» цифру. FS3017 показал себя достойно, выдав 156k IOPS.

При этом утилизация дисков и вычислительных мощностей системы не достигала 90% — это говорит о том, что узким местом является канал передачи данных. Далее я перешел к «боевым» тестам. Профиль нагрузки я выбрал наиболее распространенный: 67% чтения, 33% записи. Нагрузку генерировало 25 Worker’ов (терминология Iometer) на 5 iSCSI target’ов.

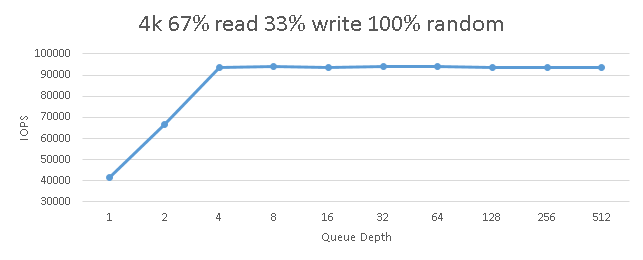

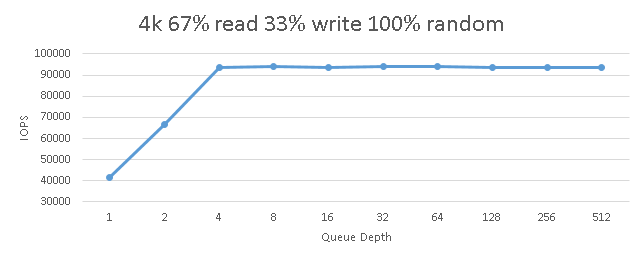

Исходя из личного опыта, указанная конфигурация AFA массива при подобном профиле нагрузки должна генерировать порядка 120-170k IOPS.После запуска цикличных тестов с повышением количества потоков я увидел следующую картину:

Как видно из графика, предел был достигнут уже при 4 потоках I/O на нагружаемый Worker и составлял ~94’000 IOPS. При этом нет дальнейшей деградации (которая всегда наступает при достижении «потолка» массива), следовательно, это значение ограничено пропускной способностью канала. Об этом говорят и показатели утилизации вычислительных ресурсов массива, не превышающие 15%.

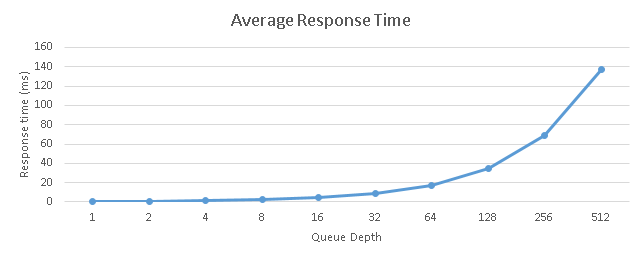

Стоит отметить взрывной рост времени задержки при увеличении количества потоков:

При достижении 4 потоков на Worker (что суммарно дает нам 100 потоков на систему) задержка составляла ~1.06 ms, после чего началась резкая деградация в геометрической прогрессии.

В дальнейшем, я планирую подключить сервер двумя портами, чтобы увидеть сколько система может выжать максимума из этих дисков. Но даже достигнутые 94 k IOPS позволяют FS3017 по праву называться AFA-системой

Система FS3017 оставила после себя очень странное впечатление: учитывая достигнутые в тестах показатели производительности, она действительно может позиционироваться как AFA-решение, однако пониженная надежность (из-за отсутствия второго контроллера) и урезанный в сравнении с конкурентами функционал ставит крест на ее использовании в серьезных корпоративных задачах. А именно этот сектор на текущий день является основным и единственным пользователем AFA-систем.

Но несмотря на это, я уверен, что она обязательно найдет свой сегмент рынка. Одним из наиболее очевидных может являться разработка корпоративных приложений и БД со сложным рельефом. В этих задачах мы можем позволить себе положить тестовую копию базы или всю тестовую среду на очень быструю и относительно дешевую FS3017 для дальнейших оперативных задач, не подвергая бизнес угрозе потерять критичные данные.

Причины появления флеш-систем (All Flash Array – AFA) достаточно просты — унифицированные гибридные массивы не справляются с огромной производительностью флеш-накопителей, а логика работы основывается на взаимодействии с классическими HDD, увеличивая время отклика системы и износ SSD. Основываясь на этом, можно выделить 3 основных отличия AFA:

- Повышенная производительность контроллеров, способная полностью «прокачать» используемые накопители.

- Оптимизированная архитектура, снижающая время отклика системы.

- Интеллектуальный функционал обработки и записи данных, снижающий износ накопителей.

Именно поэтому, когда коллеги предложили мне протестировать массив Synology FS3017, я очень удивился. Давайте вместе оценим его параметры и определимся, подходит ли он под категорию AFA.

Массив FS3017 имеет стандартное стоечное исполнение: в корпусе высотой 2U помещается 24 SFF накопителя, поддерживаются накопители различных производителей (Intel, OCZ, Seagate и т.д.), что характерно для всей продукции Synology. Но что удивило меня больше всего — так это поддержка классических HDD — это ставит под вопрос принадлежность FS3017 к сегменту AFA. Из положительного — поддерживаются накопители как enterprise-класса с SAS-интерфейсом, так и более бюджетные SATA-накопители.

В качестве процессора используются 2 x Intel Xeon E5-2620 (6-core, 2.4 GHz) v3, объём встроенной памяти составляет 64GB DDR4, и может быть расширен до внушительных 512 Gb.

В качестве сетевых интерфейсов в базовой конфигурации имеются 2 порта 10 GE с поддержкой технологии Link Aggregation, используемых как для управления массивом, так и для передачи данных. Дополнительно можно установить 2 PCI-E (x16 и x8) модуля: сетевой модуль расширения (1GbE / 10GbE / 25GbE / 40GbE) или SAS-модуль для подключения двух дополнительных дисковых полок (RX1217sas на 12 LFF-слота или RX2417sas на 24 SFF-слота).

В качестве операционной системы используется знакомый всем пользователям Synology DiskStation Manager (DSM) версии 6.1. Я ожидал, что для своего AFA Synology выпустит особую версию микрокода, но она соответствует DSM настольных и стоечных моделей. Так что же делает этот массив AFA? Как выяснилось – поддержка технологии RAID F1.

Согласно описанию производителя технология RAID F1 призвана снизить вероятность потери данных, связанной с выходом из строя всей RAID-группы целиком. Так как в отличие от HDD выход из строя SSD-накопителей обусловлен окончанием ресурса накопителя (износом ячеек), то, теоретически, возможна ситуация, когда все накопители одного рейда умрут одновременно. Во избежание такой ситуации был разработан RAID F1. Распределяя блоки данных между накопителями аналогично RAID 5, RAID F1 записывает блок с контрольными суммами дважды на 1 накопитель. Это приводит к тому, что его ресурс тратится быстрее, а значит вероятность выхода из строя всех дисков рейда уменьшается. После завершения ресурса и замены накопителя система автоматически выбирает наиболее изношенный накопитель, и начинает писать дублирующие блоки на него.

Несмотря на все заявления производителей, SSD до сих пор остаются дорогостоящими накопителями, и умышленно снижать их ресурс представляется не самым оправданным решением проблемы с точки зрения бизнеса. В то время как основные игроки AFA-рынка внедряют технологии балансировки и снижения объема записываемых данных для продления срока жизни ssd-накопителей, Synology пошли в противоположную сторону. Насколько оправдан и будет ли признан рынком такой подход покажет время.

В остальном массив FS отличается от линейки RS (стоечные массивы Synology) наличием более мощного процессора (Intel Xeon D Family), второго сокета и поддержки RAID F1. Унаследовал FS3017 и стандартные сценарии использования – список рекомендованных пакетов DSM состоит из сервера облачного хранилища, сервера заметок и видеорегистратора. Ни о какой оптимизации архитектуры и логики для использования ssd речи тут не идет, в пользу чего говорит и наличие функции SSD-кэша. Так как два из трех признаков AFA-систем не соблюдаются, остается проверить насколько массив может прокачивать наши ssd-накопители.

Систему для тестов мне предоставили с расширенной до 128 Gb памятью и 12-ю накопителями Intel SSD DC S3520 Series объемом 480 Gb. Достойные показатели производительности и доступная за счет использование SATA-интерфейса цена делают их наиболее интересными для тех, кто планирует собирать флеш-систему бюджетного класса. Я выделил 1 диск под горячую замену (поддерживается глобальная замена дисков со всех полок) и 11 дисков я объединил в RAID F1. На получившейся RAID-группе я создал iSCSI-том и презентовал его серверу под управлением Windows Server 2016. Спецификация сервера: 2*Intel Xeon E5-2695 V3 2.3 GHz 14-core, 128 Gb RAM, 2-port 10 GE Base-T. По техническим причинам мне пришлось использовать только один порт 10 GE Base-T, что явно сказалось на производительности массива.

Нагрузку я генерировал самой популярной на рынке программой синтетических тестов Iometer. Целью тестов была не производительность дисков, а самого массива, поэтому я решил использовать паттерн 4KiB 100% random.

Начать я решил с «идеальной» нагрузки в 100% read, чтоб проверить посмотреть на «красивую» цифру. FS3017 показал себя достойно, выдав 156k IOPS.

При этом утилизация дисков и вычислительных мощностей системы не достигала 90% — это говорит о том, что узким местом является канал передачи данных. Далее я перешел к «боевым» тестам. Профиль нагрузки я выбрал наиболее распространенный: 67% чтения, 33% записи. Нагрузку генерировало 25 Worker’ов (терминология Iometer) на 5 iSCSI target’ов.

Исходя из личного опыта, указанная конфигурация AFA массива при подобном профиле нагрузки должна генерировать порядка 120-170k IOPS.После запуска цикличных тестов с повышением количества потоков я увидел следующую картину:

Как видно из графика, предел был достигнут уже при 4 потоках I/O на нагружаемый Worker и составлял ~94’000 IOPS. При этом нет дальнейшей деградации (которая всегда наступает при достижении «потолка» массива), следовательно, это значение ограничено пропускной способностью канала. Об этом говорят и показатели утилизации вычислительных ресурсов массива, не превышающие 15%.

Стоит отметить взрывной рост времени задержки при увеличении количества потоков:

При достижении 4 потоков на Worker (что суммарно дает нам 100 потоков на систему) задержка составляла ~1.06 ms, после чего началась резкая деградация в геометрической прогрессии.

В дальнейшем, я планирую подключить сервер двумя портами, чтобы увидеть сколько система может выжать максимума из этих дисков. Но даже достигнутые 94 k IOPS позволяют FS3017 по праву называться AFA-системой

Система FS3017 оставила после себя очень странное впечатление: учитывая достигнутые в тестах показатели производительности, она действительно может позиционироваться как AFA-решение, однако пониженная надежность (из-за отсутствия второго контроллера) и урезанный в сравнении с конкурентами функционал ставит крест на ее использовании в серьезных корпоративных задачах. А именно этот сектор на текущий день является основным и единственным пользователем AFA-систем.

Но несмотря на это, я уверен, что она обязательно найдет свой сегмент рынка. Одним из наиболее очевидных может являться разработка корпоративных приложений и БД со сложным рельефом. В этих задачах мы можем позволить себе положить тестовую копию базы или всю тестовую среду на очень быструю и относительно дешевую FS3017 для дальнейших оперативных задач, не подвергая бизнес угрозе потерять критичные данные.