Comments 13

Как боролись с рандомизацией выдачи в Яндексе?

files.runet-id.com/2015/optimization/presentations/26nov.optimization15-4--gladkih.pdf

files.runet-id.com/2015/optimization/presentations/26nov.optimization15-4--gladkih.pdf

0

Про персонализацию и рандомизацию выдачи в курсе.

Не использовали куки, не использовали авторизацию. Парсили каждый запрос под новым ip.

Это снижает рандом. В целом оценил степень изменения и она не такая сильная. В цифрах замерять буду следующим экспериментом. Множественные запросы в рамках 1 апдейта, в разное время и таким образом оценить степень изменения. даже если учитывать указанное вами, все равно, яндекс-api (xml) не так достоверно, как выдача. основной посыл эксперимента был именно в этом

Не использовали куки, не использовали авторизацию. Парсили каждый запрос под новым ip.

Это снижает рандом. В целом оценил степень изменения и она не такая сильная. В цифрах замерять буду следующим экспериментом. Множественные запросы в рамках 1 апдейта, в разное время и таким образом оценить степень изменения. даже если учитывать указанное вами, все равно, яндекс-api (xml) не так достоверно, как выдача. основной посыл эксперимента был именно в этом

0

Авторизация, куки, прокси это не про рандомизацию, а про персонализацию.

У меня (тематика, попавшая в эксперимент) разница в выдаче 30-40%, если парсить выдачу раз в 4 часа по одному списку запросов

У меня (тематика, попавшая в эксперимент) разница в выдаче 30-40%, если парсить выдачу раз в 4 часа по одному списку запросов

0

не пробовали делать n-запросов и выводить среднее, таким образом убирать рандом?

0

Среднее мало, что даст подкидывает / понижает запросы как из 10-ки, так из 30.

Хорошую методику предложили С. Поломарь, М. Сливинский www.slideshare.net/mikeslivinsky/seo-55589153 сравнивать попарно все документы из топ 100, если документ с более низкой релевантностью занимает более высокую позицию, возможен подброс.

Только собрать столько серпов сильно проблематично.

Хорошую методику предложили С. Поломарь, М. Сливинский www.slideshare.net/mikeslivinsky/seo-55589153 сравнивать попарно все документы из топ 100, если документ с более низкой релевантностью занимает более высокую позицию, возможен подброс.

Только собрать столько серпов сильно проблематично.

0

выбрал 100 случайных запросов. снимаю каждый час позиции. рандомизация не более 20% точнее будет позже, как и возможный алгоритм снятия настоящих позиций. надо поснимать дольше и уже смотреть данные.

В рандомизации большинство +-1 позиция, потом в позициях 5+ включаю новый сайт, ближе к 10 позиции, что на траф не сильно влияет (топ3 снимает почти весь трафик)

В рандомизации большинство +-1 позиция, потом в позициях 5+ включаю новый сайт, ближе к 10 позиции, что на траф не сильно влияет (топ3 снимает почти весь трафик)

0

Давно уже было замечена не точность данных Yandex XML. Но к сожалению, это единственный легальный способ проверять позиции.

У нас на LINE.PR-CY.ru вот такие данные по ежедневным изменениям позиций:

То есть больше 40% позиций меняются каждый день. Очень часто на 1-2 позиции.

У нас на LINE.PR-CY.ru вот такие данные по ежедневным изменениям позиций:

То есть больше 40% позиций меняются каждый день. Очень часто на 1-2 позиции.

+1

С введением подобной рандомизации Яндекса анализ динамики путем сбора позиций что по XML, что по «живой» выдаче перестал быть весомым показателем.

Сейчас эффективнее анализировать трафик, нежели позиции, меняющиеся при каждом нажатии F5.

Сейчас эффективнее анализировать трафик, нежели позиции, меняющиеся при каждом нажатии F5.

0

Мне кажется вполне можно найти базовые результаты, убрав рандом.

Данные чуть позже опубликую.

А какие образом вы предлагаете анализировать траф, не очень это ясно? он либо есть по запросу, либо нету. Количество плавает от дня недели, сезона. Просто если запрос в топ5-10, то его стоит «дотолкнуть», к примеру. а если уже 1-2, то не стоит

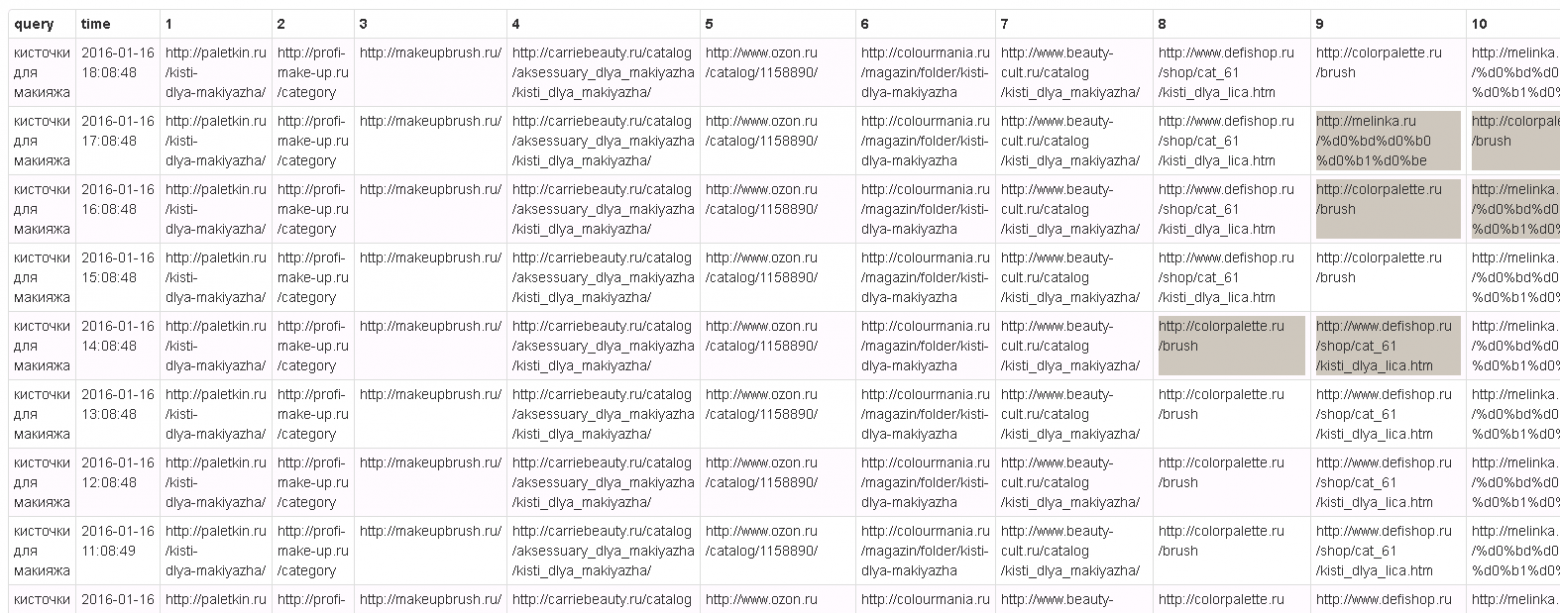

вот тут, к примеру отчетливо видно базовые:

Данные чуть позже опубликую.

А какие образом вы предлагаете анализировать траф, не очень это ясно? он либо есть по запросу, либо нету. Количество плавает от дня недели, сезона. Просто если запрос в топ5-10, то его стоит «дотолкнуть», к примеру. а если уже 1-2, то не стоит

вот тут, к примеру отчетливо видно базовые:

Большая картинка

0

Да, было бы интересно посмотреть на данные. Сколько запросов смотрите? Из какой тематики, просто у меня (последний раз проверял 12.01.16) рандом значительно сильнее. Тематика – одежда

0

Сейчас взял 100 запросов (order by rand) и снимаю каждые 60 минут, чтобы получить первичные данные. Если они окажутся интересными, будет более масштабный эксперимент. yadi.sk/i/nPMc73dunAwKa вот часть данных. посмотрите. если есть интересные идеи как провести эксперимент и как снимать данные — пишите в личку, там обсудим

0

Как анализировать трафик?

Для этого есть Яндекс Метрика и Гугл Аналитикс. По ним мы видим динамику посещений и если она положительная, то работы по сайту проведены не зря и соответственно клиент доволен и всем хорошо. Сезонность смотрим в вордстате — https://wordstat.yandex.ru/#!/history?words=%D0%BF%D0%BB%D0%B0%D1%81%D1%82%D0%B8%D0%BA%D0%BE%D0%B2%D1%8B%D0%B5%20%D0%BE%D0%BA%D0%BD%D0%B0

А позиции, которые условно говоря меняются при каждом обновлении страницы, это к сожалению уже не показатель на текущий момент (применительно к Яндексу), т.к. в отчете вы покажете 5-е место запросу, а клиент на своем компьютере увидит 11-е, ну и получится некоторый конфуз.

То что есть расхождения между XML и реальной выдачей — это давно не секрет для тех кто занимается SEO и хоть как-то причастен к продвижению сайтов, вот например статья Деваки от 2013 года «Яндекс.XML vs ТОП» https://devaka.ru/articles/yandex-xml-vs-serp — с графиками, таблицами и т.п.

На счет вашего анализатора — сервисов аналитики и проверки позиций в интернете достаточно, и практически у всех есть возможность проверки позиций как по XML, так и живой выдачи, есть анализы апдейтов по датам и куча прочих аналитических плюшек, поэтому у вас получается очередной велосипед, но, с другой стороны эксперименты лишними никогда не бывают :) сервисы навскидку

megaindex.ru

seolib.ru

http://www.majento.ru

allpositions.ru

seoplane.ru

top-inspector.ru

topvisor.ru

analyzethis.ru — интересный анализатор, в том числе и апдейтов большинства популярных поисковых систем

ПС. Ссылки почему-то не отображаются, видимо кармы не хватает…

Для этого есть Яндекс Метрика и Гугл Аналитикс. По ним мы видим динамику посещений и если она положительная, то работы по сайту проведены не зря и соответственно клиент доволен и всем хорошо. Сезонность смотрим в вордстате — https://wordstat.yandex.ru/#!/history?words=%D0%BF%D0%BB%D0%B0%D1%81%D1%82%D0%B8%D0%BA%D0%BE%D0%B2%D1%8B%D0%B5%20%D0%BE%D0%BA%D0%BD%D0%B0

А позиции, которые условно говоря меняются при каждом обновлении страницы, это к сожалению уже не показатель на текущий момент (применительно к Яндексу), т.к. в отчете вы покажете 5-е место запросу, а клиент на своем компьютере увидит 11-е, ну и получится некоторый конфуз.

То что есть расхождения между XML и реальной выдачей — это давно не секрет для тех кто занимается SEO и хоть как-то причастен к продвижению сайтов, вот например статья Деваки от 2013 года «Яндекс.XML vs ТОП» https://devaka.ru/articles/yandex-xml-vs-serp — с графиками, таблицами и т.п.

На счет вашего анализатора — сервисов аналитики и проверки позиций в интернете достаточно, и практически у всех есть возможность проверки позиций как по XML, так и живой выдачи, есть анализы апдейтов по датам и куча прочих аналитических плюшек, поэтому у вас получается очередной велосипед, но, с другой стороны эксперименты лишними никогда не бывают :) сервисы навскидку

megaindex.ru

seolib.ru

http://www.majento.ru

allpositions.ru

seoplane.ru

top-inspector.ru

topvisor.ru

analyzethis.ru — интересный анализатор, в том числе и апдейтов большинства популярных поисковых систем

ПС. Ссылки почему-то не отображаются, видимо кармы не хватает…

0

Sign up to leave a comment.

Насколько важен API или сравниваем Яндекс.XML и реальную выдачу