Comments 418

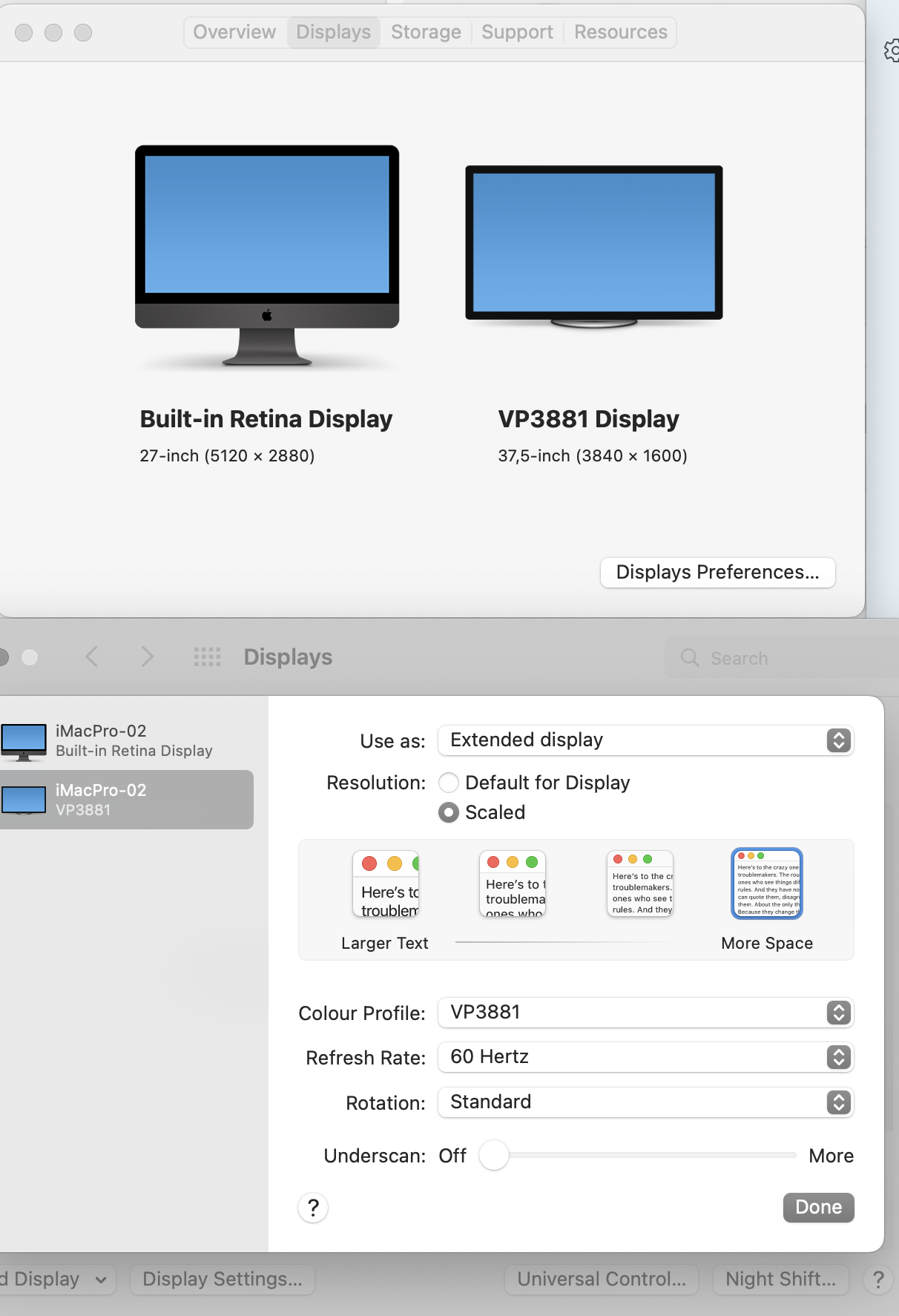

Если брать многие "нонейм" телевизоры, собираемые в нашей стране типа Декспы, Ролсены, Ирбисы, Хундаи и прочие по сути из одинаковых комплектующих, только с разными шильдиками и корпусом, то практически никто не умеет показывать компьютерное изображение также четко, как это делает монитор. Простое статичное изображение рабочего стола с иконками и названиями. И не важно что плотность пикселей как бы достаточна и они не различимы вблизи. Либо буквы и грани переходов будут слегка размытыми, либо появляются какие-то ореолы вокруг белого шрифта. Для того, кто всегда смотрел на смартфон и тут решил взять ПК оно может показаться "так наверное и должно быть", но для того кто постоянно смотрит в монитор сразу возникает ощущение "какое-то оно не такое все".

Возможно брендовые телевизоры верхнего эшелона и выдают неотличимую от монитора картинку. Но много людей берет телевизоры просто по цене. "Смотри вон 4К и такой большой и всего за 25 тысяч" Подключают его к ПК чтобы поглядеть фильмы на большом экране и видя рабочий стол понимают что "Да, телевизор это не монитор".

либо появляются какие-то ореолы вокруг белого шрифта

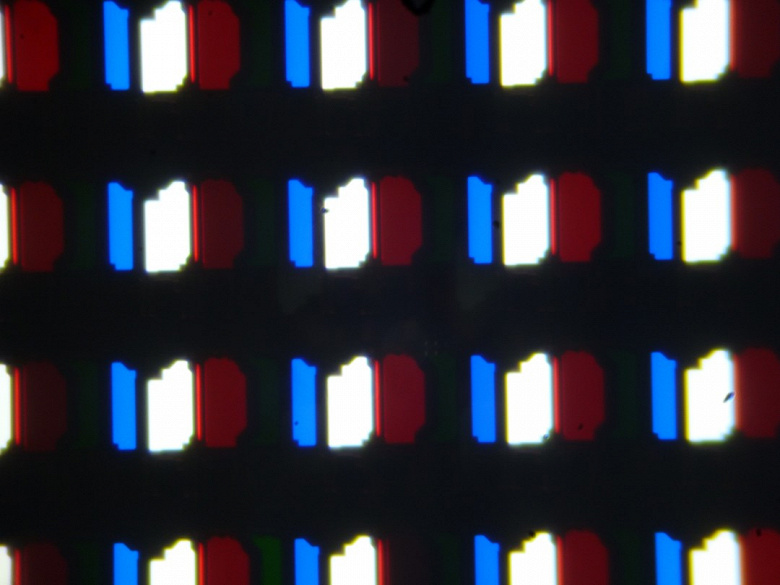

это случаем не несоответствие настроек субпиксельного сглаживания физическому расположению цветных элементов пикселя?

У многих дешёвых телевизоров аналог PenTile - зелёных субпикселей столько, сколько нужно, а красных и синих меньше.

Я пробовал, для эксперимента, сидеть за таким. Сглаживание ClearType по умолчанию выглядит вырвиглазно, но можно настроить до уровня "терпимо". Для тех, кто чувствителен к шрифтам, такое строго не рекомендуется.

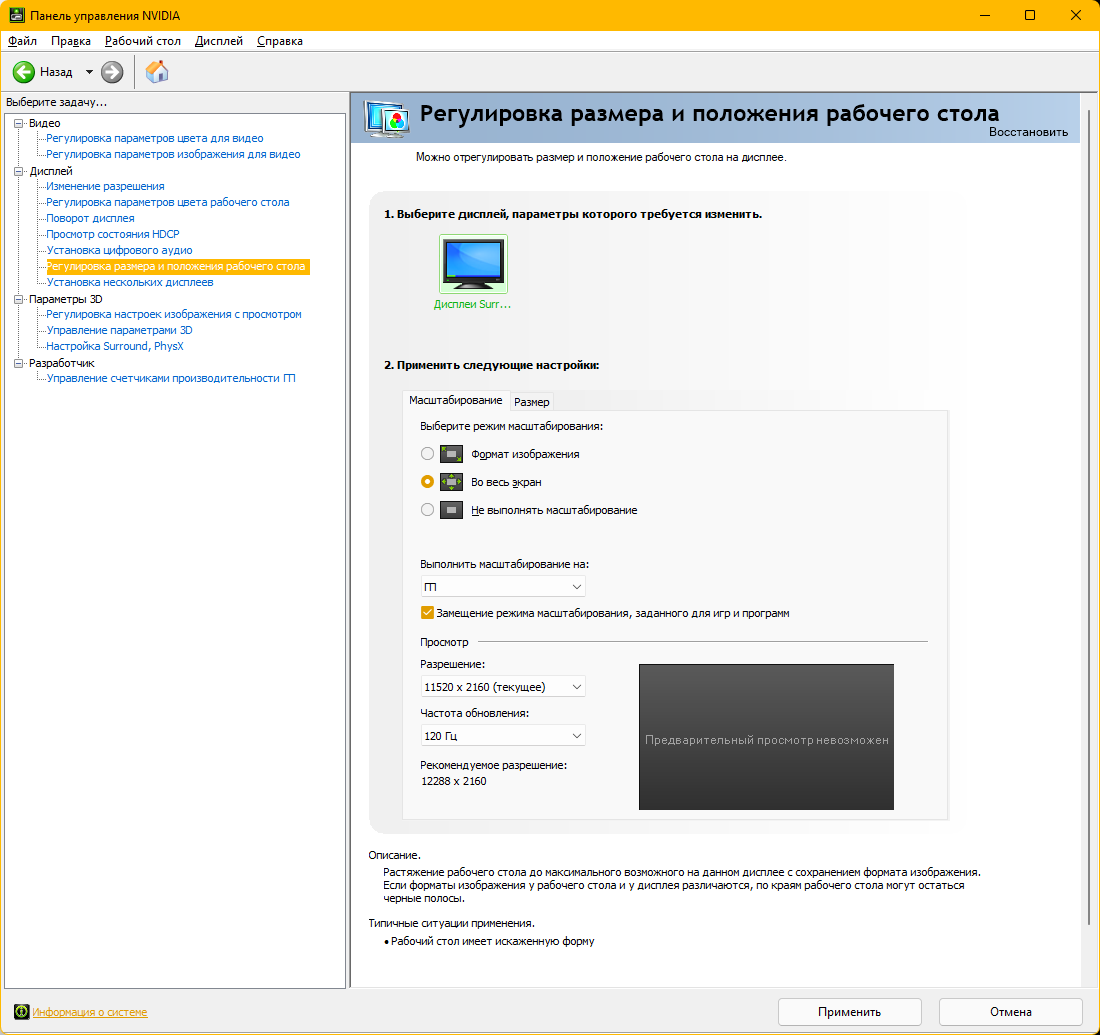

Ещё есть цветовая субдискретизация, которая любит включаться сама по себе и портит малину, и в стандартных настройках её нет - она обычно закопана в настройках драйвера видеокарты. Просто картинка становится какая-то не такая, и пользователь не понимает, что, как и почему.

Ещё есть цветовая субдискретизация… Просто картинка становится какая-то не такая, и пользователь не понимает, что, как и почему.По поводу цветовой субдискретизации я чуть ниже ответил, как это можно проверить, и как можно попробовать исправить

https://habr.com/ru/post/682140/#comment_24622464

Хуже, если матрица телевизора RGBW — это уже никак неизлечимо.

(или просто отключить сглаживание в любых версиях Windows).

Хуже, если матрица телевизора RGBW — это уже никак неизлечимо.

так отключение субпиксельного сглаживания должно помочь и с rgbw. или вообще сглаживание можно оторвать, при достаточном разрешении и без него хорошо

так отключение субпиксельного сглаживания должно помочь и с rgbwУвы, нет (ну, или во всяком случае не на всех типах RGBW матриц).

Дело в том, что в строке половинное цветовое разрешение — четные пиксели RGB, а нечетные W

А в следующей строке наоборот — честные пиксели W, а нечетные RGB.

Т.е из двух соседних пикселей только один цветной, и при этом втрое шире соседнего белого.

Так что в лучшем случае мы получим половинное разрешение, а в худшем еше и нервные (“рваные“, “узловатые“) вертикальные линии.

Стоит упомянуть, что RGBW матрицы бывают разные. У меня, например, RGBW, включено сглаживание, а шрифты нормальные. Почему? Потому что пиксели полноценные. Красный, зелёный, синий, белый в каждом пикселе.

А есть другой, более распространённый вид RGBW матриц - в них число субпикселей разное. И вот на них всё плохо. Точно также, где матрицы RGB, но тоже - красных и синих меньше.

Таким образом, для шрифтов самое главное - полноценные пиксели, состоящие, как минимум из 1 зелёного, 1 красного и 1 синего субпикселя.

Стоит упомянуть, что RGBW матрицы бывают разные.Так я же сказал: “… во всяком случае не на всех типах RGBW матриц....“

Хотя сам вживую телевизоров с

Красный, зелёный, синий, белый в каждом пикселепока не встречал.

Во всяком случае при покупке телевизора с RGBW матрицей ИМХО обязательно надо выяснять, какая у него субпиксельная структура, особенно если предполагается использование телевизора в качестве монитора, «чтобы потом не было мучительно больно»©

₽$ Что за модель телевизора, если не секрет?

Или если можно макрофото субпиксельной сетки (качество не так важно, просто чтобы была различима субпиксельная структура)

LG OLED C1, на всех трёх пиксели нормальные (т.е. нет разницы от экземпляра к экземпляру)

Примеры

LG C9, LG CX, C1, C2

Вы путает это с RGBW с WRGB. Это разные вещи, OLED имеет в каждом пикселе 4 субпикселя.

Либо буквы и грани переходов будут слегка размытыми,Это бывает, если телевизор отображает не пиксель-в-пиксель. Хотя казалось бы разрешение на видеовходе совпадает с нативным разрешением его экрана, но…

Иногда это можно «вылечить» настройкой, причём не всегда самоочевидной — например нужно переименовать видеовход телевизора, к которому подключён компьютер (да, просто присвоить ему «правильное» название), и проблема решается.

Хотя к сожалению это решение далеко не универсальное.

либо появляются какие-то ореолы вокруг белого шрифтаЭто бывает, если телевизор работает не в полном цветовом разрешении 4:4:4, а в 4:2:2 (а то и в 4:2:0).

Почему он так делает — вопрос другой, у меня была статья на habr на эту тему

Кстати, этот тест выявляет и проблемы с отображением пиксель-в-пиксель (см первую часть ответа), но к сожалению очень чувствителен и к масштаб у отображения (требует строго 100% по всему тракту от gif-ки до экрана).

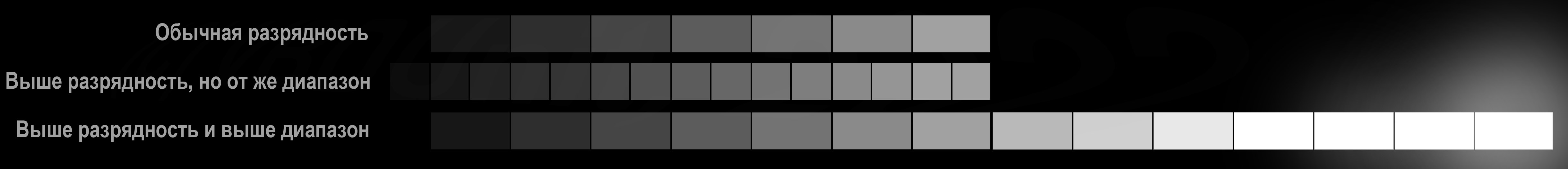

В общем, если вы на этой картинке хорошо видна надпись 4:4:4 и практически неразличима 4:2:2, то значит всё настроено правильно — отображение пиксель-в-пиксель с полным цветовым разрешением.

Если наоборот, видно 4:2:2 и почти неразличимо 4:4:4 (или видны обе-две надписи), то либо какие-то проблемы с отображением пиксель-в-пиксель, либо не полное цветовое разрешение, либо просто масштаб отображения картинки не строго 100%

Про масштаб надо было сверху написать, а то блин топовый ноутбук 13 дюймов, 4K, OLED, плотность пикселей за глаза, шрифты почти голографического качества - а реально видно 4:2:2 при 100% масштабе.

В общем кроме масштаба страницы ещё есть масштабирование дисплея и вот если его тоже убрать то тогда уже 4:4:4 становится конкретно видно как надо (правда пользоваться неудобно когда всё настолько мелкое).

Про масштаб надо было сверху написатьПро 100% масштаб я и сверху написал (сразу за ссылкой на статью), и снизу (прямо над gif-кой), и в самой статье в нескольких местах, и в её обсуждении (в шапке темы, и нескольких ответах).

Безусловно, необходимость выставления 100% масштаба — самое слабое место моего теста, но я ненастоящий

Хотя это наверняка можно сделать, и в обсуждении статьи этот вопрос поднимался, но потом также и угасал.

А для меня это увы, нерешаемая задача...

кроме масштаба страницы ещё есть масштабирование дисплея и вот если его тоже убрать то тогда уже 4:4:4Угу, об этом у меня написано (в сообщении сразу под ссылкой на статью, и в самой статье).

Это одна из причин, по которой я так и не смог сделать «масштабонезависимый» тест, и решил ограничиться gif-кой и устными предупреждениями про необходимость строго 100% масштаба по всему тракту от gif-ки до экрана.

Хотя это конечно неидеальное решение (юзверь сам должен разбираться с масштабами во всех возможных местах), но увы, лучше я не смог сделать…

Про масштаб надо было сверху написать

Тут я тоже ненастоящий сварщик IT-шник. Просто согласно фокусировке внимания людей (для себя так объяснил) - я сперва увидел картинку (на которой 4:2:2 видно значительно лучше чем 4:4:4), следующая точка фокусировки попала на строку с выделение жирным текстом про то что если вы видите это то у вас проблема. И всё это краем глаза на подсознательном уровне, сразу после прокрутки экрана к следующим комментариям. Следующим действием пошло уже разбирательство что с экраном не так, вплоть до определения производителя моей матрицы и процента брака подобных девайсов. А потом уже прочитал строку ниже что надо масштаб выставить 100%.

В общем просто интересный баг восприятия комментария вышел :)

А тест очень наглядный, правда ещё момент заметил что при подключении 2 монитора по VGA кабелю если провод расположить рядом с сетевым шнуром то видно 4:2:2 если отодвинуть то только 4:4:4, настройки монитора и компьютера при этом не меняются. Забавно :)

заметил что при подключении 2 монитора по VGA кабелю если провод расположить рядом с сетевым шнуром то видно 4:2:2 если отодвинуть то только 4:4:4, настройки монитора и компьютера при этом не меняются.Тест очень чувствительный ко всему «постороннему», например если сильно сбита настройка Gamma, или переборщили с резкостью, а в вашем случае какие-то наводки на аналоговый сигнал.

Это уже выяснилось после того, как я его сделал, и написал статью.

Так что по сути это получился не совсем тест цветового разрешения 4:4:4 vs 4:2:2, а комплексный тест всего видеотракта:

— Если вы вместо (или помимо) 4:4:4 видите 4:2:2, то у вас или неполное цветовое разрешение, или отображение не пиксель-в-виксель, или какие-то отклонения в настройке изображения, или проблемы с видеоинтерфейсом, или просто не соблюдены условия теста (т.е масштаб на каком-то из этапов по всей цепочке от gif-ки до экрана не 100%)

— Если же вам все же удалось добиться того, что вы видите 4:4:4 и практически не видите 4:2:2, то у вас полное цветовое разрешение, и отображение пиксель-в-виксель, и вообще с видеотрактом все более менее в порядке.

Т.е тест может давать ложно-отрицательный результат, но ложно-положительный результат практически полностью исключён. Там простая математика, см.обуждлении статьи.

₽$ Теоретически может быть положительный результат теста при половинном разрешении, и отображении пиксель-в-2x2пикселя, но мониторов, умеющих так делать почти нет (см FullHD vs 4k и integer scaling: всегда ли 2 x 2 = 4?), так что и в этом случае результат теста был бы не ложно-положительным (вряд ли можно не заметить, что монитор работает с половинным разрешением), а положительным для выявления таких мониторов.

У меня после частичного апгрейда моего 12-летнего стационарника до более-менее свежего, пропал выход DVI-A, которым он подключался к "монитору со встроенным TV-тюнером", подключил по D-SUB (какой кабель был в загашнике, из имеющихся интерфейсов и там и там), и изображение "поплыло". Пришлось срочно идти за HDMI - помогло. А так, и подрагивания были, и "мыло" и вообще, смотреть невозможно. Так что "стандартный VGA-кабель" уже пора считать изжившим себя.

А уж как лучше видно в RGB!

Вот кстати странно читать про гонки за субпиксельной четкостью и отображением пиксель-в-пиксель, когда у меня последним монитором, за которым можно было нормально работать без масштабирования, был 17 люймовый ЭЛТ.

Здравствуйте. Очень интересная гифка у вас получилась. Еще давно заметил, что OBS-studio портит цвета при записи.... И у меня не получилось настроить OBS, чтобы эта картинка на записи воспроизводилась правильно. Может быть подскажите, как нужно настроить OBS???

Проблема в проигрываетеле, только mpv правильно управляет цветом на все 3 уровням.

Если Вы используете формат записи со сжатием, то "магия" картинки (выравнивание элементов "надписей" строго по границам пикселей) будет беспощадно разрушена сжимающими алгоритмами. Или писать в несжимаемый формат (но это большой объём, и нужны совместимые проигрыватели). Так что лучше просто - сохраните gif как файл.

Думаю зависит от улучшалок по умолчанию и хитрости производителя. Пробовал какой-то дешевый тв — ощущение что там фуллхд только на этикетке, а в реальности даунскейл до какого-то нестандартного разрешения матрицы.

Еще на старых телевизорах была темная сетка между светящимися пикселями, очень даже заметная

Это называется кристаллический эффект, ни в одном нормальном телевизоре этого нет.

Вот тут ИМХО хорошее описание 😲

Я его могу видеть (для этого слегка покачать головой глядя на экран с обычным изображением, ощущение примерно как при взгляде вдаль в жару через марево), и не могу не замечать, потому что от него действительно устают глаза (в отличие от той же межпиксельной сетки или крупного пикселя).

К счастью работать за такими мониторами мне не приходилось (тьфу^3), своих таких тоже не было (тьфу^3), но вот видеть доводилось (в т.ч у коллег на работе).

Многие его не видят, а замечают по красным «рачьим» глазам, глядя в зеркало после работы за таким монитором.

Проявляется на некоторых матовых мониторах как раз с мелким (!!!) пикселем (к счастью не на всех). Т.е по ТТХ монитор вроде бы хороший, пиксельная сетка и пиксели не видны, но…

От чего это ещё это зависит, и почему проявляется не на всех мелкопиксельных матовых мониторах я не могу объяснить (впрочем, может я не на всех его вижу, а он там есть).

Насколько часто проявляется (и проявляется ли) кристаллический эффект на современных мониторах тоже не могу сказать.

Правда потом может возникнуть вопрос, «как это развидеть»

ЕМНИП я подобное встречал лет 10-15 назад на мониторах (если не ошибаюсь) Dell или HP от графических рабочих станций (к счастью не на своём — у меня был CRT монитор Mitsubishi DiamondTron, который мне удалось отстоять). Позже тоже видел, но точно уже не вспомню где, и на чем.

Проявляется ли кристаллический эффект на современных мониторах не могу сказать — с начала пандемии я намного меньше имею возможности их смотреть.

Правда я полиграфист и мониторы всегда были — соответствующие

мониторы всегда были — соответствующиеМожет в этом «собака и порылась»?

Хотя на графстанциях тоже было что-то крутое по тем временам. Я тогда ЕМНИП первый раз столкнулся с мелкопиксельными LCD, и… начал ещё крепче держаться за свой старый-добрый CRT DiamondTron.

₽$ А в полиграфии разве не глянцевые мониторы?

У меня недавно стало проявляться что-то. Сначала на амоледе смартфона, потом стал это видеть и на NEC 2090UXi, на котором уж текст-то точно должен отображаться идеально (раньше так было). Сейчас стало проявляться и на экране планшета (Huawei Mediapad M5). Не самые плохие экраны во всех случаях.

Возможно, что-то со здоровьем (в обоих смыслах) =) Видится все это боковым зрением, при попытке сфокусироваться исчезает. На NEC предстает как мелкая пиксельная сетка при просмотре текста на белом фоне (как сейчас). Причем это точно не связана с разницей обработки одного сигнала разными глазами, потому что при раздваивании и просмотре изображений каждым глазом сохраняются все присущие этому способу эффекты, связанные, как я понимаю, с индивидуальными особеностями глаз. У меня, например, яркость левой картинки ниже, чем правой, потому что я правша, и по некоторым другим критериям. То есть для меня активный глаз в обычном состоянии - правый, но это можно поменять, хотя и не просто. Тогда меняется и яркость, и четкость, и многое другое.

Такое ощущение, что мозг словил некий паттерн восприятия и теперь раз за разом пытается его воспроизвести, когда не уверен в том, что видит. А не уверен он в том случае, когда изображение обрабатывается в фоновом режиме.

Отключите ClearType, он не подходит для OLED.

И вот мы смотрим на дисплей с «достаточными глазу 60 Гц», по которому движется кура-гриль. Мозг хочет сопроводить куру-гриль взглядом, и ожидает, что мир вокруг будет вертеться, а в центре будет неподвижная чёткая кура-гриль. Но, вместо этого, на сетчатке глаза будет размытое, дёрганое и попердоленое пятнышко.

что такое попердоленое не знаю, опустим.

что на 60 Гц будет дёргаться больше, чем на 120 — понятно.

а почему размытое? разве время переключения пикселя как-то связано с частотой обновления?

Вы правы, технически эти параметры не связаны. Но, как правило, в то, что имеет максимальную частоту обновления 60 Гц, ставится довольно медленная матрица

Но размытость то тут всё равно не при чём. Да еслиб размытость не на видеокарте можно было делать... столько нагрузки можно было бы снять с видеокарты! Как раз те % которые дают разницу между какой-нить 3070 и 3090!

Имелось ввиду не размытие в движении, а полупрозрачное совмещение двух кадров. Вероятно, правильнее было бы употребить термин "смазанное".

К слову, Half-Life 2 я заметил очень интересный эффект - игра старая, поэтому 120 Гц видеокарта выдаёт без проблем. В игре нет эффекта размытия в движении, но я его увидел: если например, раскрутить карусельку в начале игры, то она будет выглядеть смазанной, если же при этом начать следить за ней взглядом, то размытие пропадает, как в жизни. То есть, при высокой частоте кадров размытие в движении появляется само собой, причем это уже не имитация - если следить глазами, оно пропадает.

Ну да, крутящиеся вещи некорректно отображаются. Только чтобы правильно увидеть как вращается колесо потребуется даже больше 450 кадров)

Ну, технически, можно доработать шейдер размытия в движении, чтобы там были не просто вектора, как сейчас, а, например, трёхточечные кривые. Тогда оно сможет делать криволинейное размытие движения и колесо будет выглядеть сносно.

Нюанс в том, что если попытаться глазами проследить за таким размытым колесом, то оно останется размытым. А на высокой герцовке оно станет чётким, как это и происходит в жизни.

Так-то там вообще нет шейдера размытия в движении самой карусельки.

Потратиться на шейдер, это, условно, потратить на карусельку средств, как на пол игры) А на следующий крутящийся элемент скорее всего придётся писать новый шейдер.

Там нет шейдера размытия, я имел ввиду, что такой шейдер можно сделать. И я имел ввиду сделать универсальный шейдер на всю игру. То есть, сейчас в играх размытие делается шейдером, который на вход принимает картинку и информацию о векторах движения. Моя мысль заключается в том, чтобы эти векторы движения заменить на трёхточечные кривые, каждому пикселю соответствует своя. И размывать вдоль таких кривых.

Это сделать довольно несложно, просто это практически никогда не будет заметно, а вычислительных ресурсов будет потреблять значительно больше.

Именно.

Мозг все равно распознает в дерганой картинке движение, но для этого ему приходится ее размыть. Длина размытия как раз соотвествует пройденному растоянию между соседними кадрами. Поэтому чем больше частота обновления (естественно частота кадров не должна оставать) - тем четче движущийся по экрану объект. Есть лайфхак: если отключать картинку между кадрами - размытие уменьшается пропорционально времени которое экран провел показывая черноту. Так работают ЭЛТ и технологии стробинга. Про это есть целый сайт, крайне рекомендуется к ознакомлению перед покупкой нового экрана.

Вставка черного кадра привносит жуткое мерцание и картинка становится темнее.

Важно отметить, что вставка чёрного кадра - это не то же самое, что происходит в ЭЛТ и плазмах. Там развёртка, как если бы строки изображения мерцали не одновременно, а последовательно, и происходило бы это очень быстро + вспыхивание происходит почти мгновенно, а затухание плавно.

Поскольку мерцает экран не весь, а по одной строчке, суммарные колебания светового потока гораздо ниже, из-за скорости мерцание не так заметно и т.п. - это очень сильно отличается от просто мигающего экрана с ШИМ или вставкой чёрного кадра.

У меня есть плазма с развёрткой 2000 Гц - это не то же самое, что 2000 к/с, конечно же, но на ней объекты остаются абсолютно чёткими и не размытыми, даже если двигать их быстро.

Кот, кстати, больше всего обращает внимания на движущиеся объекты на плазме - насколько я знаю, у них скорость зрения больше, чем у нас, поэтому все артефакты, связанные с низкой кадровой частотой, по логике, они должны видеть лучше.

Вставка чёрного кадра увеличивает плавность, насколько я знаю, потому, что мозг автоматически удаляет эти моменты и сам заполняет соседними кадрами уже в памяти. Т.е. это как-бы тоже "уплавнялка", только реализованная в мозге, а чёрный кадр - способ её заставить работать.

В моих C1 вставку чёрного кадра можно не только включать/выключать, но и регулировать степень мерцания - слабо, средне, максимально, автоматически.

Так какие конкретно модели телевизоров автор рекомендует?

Телевизоры это до сих пор компромиссы, если брать oled, условно под 5 плойку и под фильмы, то выходит, что есть только lg c1 / g1, ну возможно bravia наконец подтянулись, но и цены на них слишком высокие, вот и весь выбор. Есть конечно самсунг со своим qled, но что-то совсем не то.

С мониторами кстати тоже далеко не всё хорошо, либо фильмы и работа, либо игры. + огромнейший пласт мусора, как в прочем и с телевизорами.

В итоге хочешь купить телевизор, начинаешь изучать, начинаешь плакать от всего этого несовершенства или цен, которые впрочем тоже не гарантируют, что это не очередной мусор)

Зато qled не выгорит, это просто неплохой ЖК экран с кучей маркетинга. Надо тестить, не уверен что эти динамические подстветки хороши для работы с ПК

Олед выгорит тогда, когда он уже морально устареет, ечли грубо говоря нужен телевизор на 3-5 лет, о выгорании можно не парится, тесты ртингс это наглядно демонстрируют

Ну и к тому же, дел уже выпустил первый qdoled монитор с гарантией на выгорание 3 года, так что лет тронулся

Буква Q в начале как-бы намекает на не совсем обычный ЖК экран :)

У него светодиоды тоже дохнут. У меня монитор QLED и LG C9. Qled больше не пользуюсь.

C2 и G2 уже)))

Ну и самсунг выпустили кдолед, из телевизор шдр для фильмов это сейчас топ1

Самсунг s95b или Сони a95k

Про мониторы глупость полнейшая, как раз самые хорошие мониторы сейчас универсальные, и фильмы с работой и игры.

Например у того же эйсера иодели 2к 240гц имеют очень хорошие характеристики, не только для игр, но и для работы с графикой и цветом, есть конечно моники еще лучше, но там сразу цена х2-3

Про с2/g2 не знал, нужно будет посмотреть.

По поводу моников: покажите примеры 4/5к моников, от 120Hz с нормальных охватом, поддержкой dolbi hdr? Про олед не пишу тут.

s95b интересный, но тоже не без недостатков видимо

лучше s95b нет ничего, просто как факт... все от него просто текут слюнями

разве что g2 может с ним потягаться, но и то... насыщенность цветов хуже и типичные косяки wrgb

по моникам 4/5к честно без понятия, я их даже не рассматривал к покупке, нет карт которые могут тянуть игры в таких разрешениях, даже 3080 слабовата, даже для 2к... какие там 4/5к, поэтому даже для 2к-240 хочу менять на 4080

ну и не нужны людям которые работают с цветом профессионально 120гц, не те задачи, работа с цветом и игры все же абсолютно разные задачи

поэтому 2к-240 сейчас самое то, можно и матрицу быструю получить, а 2к нормально для большинства людей, и охват цветовой очень хороший - 99% аргб, долбивижн шдр вообще на мониторах не нужен, да и на телевизорах тоже, слишком много шуму ради 0,5% разницы которую нужно под лупой искать, мониторы с шдр 1000 стоят столько, что нафиг они нужны, лучше телевизор хороший купить, дешевле выйдет ))))

4k@120 показывают не требовательные игры, шутеры, даже ps5 вроде с динамическими 4к в каких-то шутерах/гонках показывает 120.

Ну и, условно на 32 дюймах, уже мало 2к, хочется 4, да и в любом случае вы будите видеть не только игры, но и интерфейс в 4к)

32 для монитора много, приятель купил такой, фигня фигней, уже неудобно, либо его ставить надо дальше, но тогда и угловой размер будет как у обычного 27", так и смысл тогда в нем какой непонятно.

Динамическое 4к на консолях это как 1080 на пк, знаю я эти консоли, на словах все круто, а на деле ничего не тянут. Не знаю в чем там 120 при 4к, разве что в тетрисе. Ну и к тому же, после 240, 120 уже очень мало, я уже даже к 240 привык и хочется еще больше, но это соревновательные шутеры или тот же дум, в сингловых играх 3080 не может даже 100 стабильно выдать в 2к разве что костыль длсс спасает), какие там 4к... Вот и получается что 2к еще надолго будет лучшим выбором. Ну и матрицы 2к банально лучше и дешевле в разы, глянул сейчас ради интереса 4к моники в тестах, нет ничего даже близкого, либо сильно хуже, либо сильно дороже, за такую стоимость уж лучше тогда взять оверпрайснутый 2к с hdr 1000 :) можно и широкоформатный

А s95b офигенный телек, купил бы с удовольствием и цена приятная, 1600 долларов за 55" и 2200 за 65", хотя была акции и вроде за 1800 отдавали, а это дешево для такого телевизора. Но это все там.... В нормальных странах, у нас почти 3000 за серый 55", а это уже проще 77 с2 взять, пусть и тоже серый

Вот и пришли к выводу, что 4к моников нету)) Либо цена и то с оговорками, либо печаль в виде ттх)

Раньше мне было нужно либо два 27 монитора, либо один 32, но сейчас всё же вообще отказался от монитора: ноут и телик с консолью для отдыха. Вот как раз для хорошего отдыха придётся рассмотреть последние lg и этот самсунг :)

А по поводу 4к в консолях, то безусловно проблемы там будут, но даже в таком случае есть возможность смотреть 4к контент + использовать 120 Hz для меньшего разрешения. Всё же как ни крути 4к уже хочется иметь и это просто приятно

Погуглите bfgd monitor, будете, возможно, приятно удивлены.

Например, ASUS ROG Swift PG65UQ - 64", 4k, 144Hz. И да, монитора много не бывает.

65" это телевизор, никакого отношения к мониторам он уже не имеет, а асус, 450 000 за ВА телевизор?

спасибо, не нужно даже бесплатно... проще уж тогда купить 77" oled телевизор, а на сдачу 34" изогнутый монитор с тем же шдр 1000...

А после какой диагонали монитор превращается в телевизор? Я как-то в магазине смотрел на 58" изогнутый самсунг, 21:9, это еще монитор или уже телевизор?

77" олед телек умеет 144 Гц?

А после какой диагонали монитор превращается в телевизор?

Монитор — устройство оперативной визуальной связи пользователя с управляющим устройством и отображением данных, передаваемых с клавиатуры, мыши или центрального процессора. Принципиальное отличие от телевизора заключается в отсутствии встроенного тюнера, предназначенного для приёма высокочастотных сигналов эфирного (наземного) телевещания и декодера сигналов изображения

Извините, внесу 5 копеек- уже не принципиальное. Больше смотрит в смарт по тому же интернету. Тюнер - во многом пережиток, стоит по умолчанию . Раньше еще была такая тема- вешали монитор плюс внешний ТВ-тюнер, никакого различия, кроме того что нет пульта ДУ. Надо править wiki или что там.

У монитора этого нет, он из коробки и воткнутый в розетку — покажет только меню настроек изображения

Принципиальное отличие от телевизора заключается в отсутствии встроенного тюнера, предназначенного для приёма высокочастотных сигналов эфирного (наземного) телевещания и декодера сигналов изображения

Не важно, тюнер там, или смарт, или что-то еще — это автономная вещь в себе, которая настроена на прием чего либо широковещательного прямо из коробки. Воткнул в розетку и смотри.На самом деле тут «все чудесатее и чудесатее»©

Существуют / были / планируются:

- Мониторы с TV-Тюнером (в т.ч. DVB-T2 и эфирным), со Smart TV или без него

- Телевизоры без эфирного TV тюнера (только Smart TV)

- Мониторы со Smart TV (без эфирного TV тюнера)

- Телевизионные панели без TV тюнера (ресивер — отдельная опция)

- TV-мониторы (с TV-тюнером, обозначение модели «мониторное»)

- Монитор-телевизоры (с TV тюнером, обозначение модели «мониторное»)

₽$ В этом классе у этого изготовителя еще более чудесатее и чудесатее, любопытственнее и любопытственнее, страннее и страннее:- «Старшая» модель с аналоговым и DVB-T2 тюнером со Smart-TV позиционируется как

Smart TV (обозначение модели «телевизионное») - «Младшая» модель с такой же матрицей, такой же «мониторной» частью, тюнером с DVB-T2, но без Smart-TV позиционируется как

Монитор-телевизор (обозначение модели «мониторное»)

- «Старшая» модель с аналоговым и DVB-T2 тюнером со Smart-TV позиционируется как

Какой шильдик будем клеить?

Нет — значит монитор

Я уже упоминал, что до сих пор являюсь "счастливым обладателем монитора со встроенным TV-тюнером" - поверьте, это совсем не "телевизор с компьютерными разъёмами" - это типичный для своего времени (2007 год, однако) мультимедийный монитор, имеющий помимо достаточно прогрессивных по тем временам DVI, D-Sub и HDMI, ещё антенный вход на внутренний ТВ-тюнер, к слову, отвратительнейшего качества тюнер, ну и типичные для мониторов (тех лет) настройки центрирования (и, вроде, даже компенсации геометрии) изображения, чего в телевизорах (уже?) практически не встречалось. И да, у этого же монитора в линейке был брат-близнец с суффиксом "mm" вместо "tv", без тюнера.

77" телек умеет 120

120-144 одна фигня, все равно после моника на 240 это очень мало, даже 240 уже мало и хочется 360

Изогнутые моники фигня, особенно такие широкие имеют в играх слишкои большое искажение с боков. Ну либо ставишь маленький угол обзора в игре, но тогда по вертикали обзор будет через щель...

32" 16*9 еще куда не шло, да и то фигня изза размера пикселя, 27 золотая середина, все что больше уже проще телек купить.

Ну, как владелец 40" 4k 16:9 пожалуй, соглашусь, что разрешение низковато, но я в основном брал его под игры, а смотрю сериалы и в таким использовании он хорош. Асус был как пример что большие мониторо-телевизоры есть, которые идут с упором на мониторную картинку. Их много разных, есть и 55" OLED от Alienware со 120 Гц, вопрос лишь цены. Но да, хочется 8k, если честно, на таких диагоналях.

Вроде? Как бы это её ключевая фишка. Как и Xbox.

А s95b заинтересовал/заинтриговал прямо)

99 Adobe RGB это очень маленький озват, вы издеваетесь? Тем более это в площади, это уже никого не волнует, всем объем (HDR) подавай.

Это все понятно, но OLED в качестве монитора - гонка со временем за выгорание. И в этой гонке Вы победителем не выйдите. Если у оледа пиксель включен, то его часики уже тикают. Он уже деградирует. Причем, чем выше яркость, тем быстрее. По этой же причине у панелей LG белый на весь экран не белый, а серый. Они агрессивно сбрасывают яркость, чем больше белого на экране. Причем, панель физически может выдать белый как белый, но она "кончится" очень быстро.

Эх, стоил бы Sony HX310 раз этак в 10 меньше...

Это да. С другой стороны такая же проблема была у плазмы, вроде, причем такие экраны морально устарели раньше, чем выгорели. Да и у классических кинескопов тоже же было выгорание, вроде.

У ЖК-панелей свои проблемы, они хоть и не выгорают, но сгорает подсветка, которую менять довольно дорого. У мониторов о таком не слышал, но у телевизоров частое явление почему-то.

А вообще по практике могу сказать - у меня два года смартфон с OLED, пользуюсь очень интенсивно (буквально из рук не выпускаю) и пока никаких признаков выгорания.

Не отрицаю выгорания OLED, такая проблема есть, просто это не говорит о том, что другие виды дисплеев вечные.

Тут речь именно о сценарии использования. В качестве телевизора - ок, ибо статичных изображений мало (логотипы и т.п.) и панель деградирует более-менее равномерно, отчего и не заметно. Но в роли монитора это уже другое дело. Тут наоборот, сплошь статичный контент. IDE, браузер, панели системы и прочее. Разве что использование ПК ограничено игрушками и просмотром видео.

Кстати, интересное наблюдение - телевизоры с лампами CCFL работают больше 10 лет и там проблема с подсветкой чаще в высыхании электролитов в блоке питания, что чинится быстро и недорого. А вот телевизоры с LED подсветкой иной раз не живут больше 2-3 лет и там действительно менять светодиоды очень дорого и неудобно, поскольку нужно разбирать всю матрицу, перепаивать светодиоды и собирать все обратно, боясь сломать очередной огромный хрупкий лист. Почему то производители не хотят сделать свои телевизоры хоть как то более ремонтопригодными, сделать чтобы хотя бы светодиоды менялись не изнутри корыта с матрицей, а снаружи, без разборки всей матрицы, что вообще не представляет никакой технической сложности. Налицо действительно какой то заговор производителей)

А ведь помню времена, когда LED-подсветка в телевизоре называлась преимуществом и такие модели стоили чуть дороже. Вообще возможно там не заговор, а банально так дешевле сделать. А ремонт уже проблема пользователя.

Меня больше удивляет, что о массовом выходе из строя мониторов через два-три года я не слышал, хотя там тоже LED-подсветка.

Ничем не дешевле, как мне кажется. Наштамповать дырок и расположить светодиоды снаружи, а не внутри - не представляет вообще какой-либо проблемы. Тем более что светодиод с рассеивателем торчит по высоте намного больше толщины металлического листа, на равномерности распределении светового потока это никак бы не сказалось.

У мониторов намного меньшая площадь и нет постоянной работы на высокой яркости, поскольку пользователь сидит в непосредственной близости. И там вместо нескольких мощных светодиодов с рассеивателями используют матрицу огромного числа мелких светодиодиков. Это дороже, но обеспечивает бОльшую равномерность засветки, что более актуально для монитора, чем для телевизора. Большое число мелких диодов очевидно работают в более щадящем тепловом режиме, чем один мощный. Непонятно, почему так не делают в телевизорах. Может, есть проблема с изготовлением и монтажом такой большой печатной платы.

Зависит от телевизора, у некоторых как раз через ~4-5 лет лампы делали ВСЁ и привет колхозный тюнинг на LED подсветку, то время как некоторые телевизоры с LED подсветкой уже 10+ лет работают.

Скорее всего, всё, как обычно, в цене вопроса: раньше подобные телевизоры были дороже и можно было позволить конструкцию сделать лучше, вплоть до того чтобы банально не перегревались элементы от длительной работы, а когда телевизор дешевый, то экономия идёт вообще на всём.

Светодиоды работают на максималке.

Обычно мастера, что перебирают подсветку, дополнительно уменьшают ток светодиодов.

Правда, цветовые характеристики улетают в мусорку.

На максималке - только если его гонять на максимальной яркости

Не факт, может быть просто ШИМ. У меня были Benq XL2411 (которые с 3D Vision) - у них, если яркость выставить меньше 100%, включается хардкорный ШИМ с перепадами от 0% до 100%.

Хотя, по факту, это всё равно снижает нагрузку - светодиоды всё равно меньше греются.

Хотя, по факту, это всё равно снижает нагрузку - светодиоды всё равно меньше греются.

Да, я именно это и имел в виду.

У меня опыт около десятка матриц.

И во всех (кроме одной, там сгорела лампа) СД умерли по перегреву, у некоторых СД люминофор так растрескался, что осыпался.

На номинале, температура линеек была в районе 80-90 градусов (телевизоры ЛГ, Самсунг).

Учитывая, что я ковырял бюджетные серии, со стеклостолитовыми линейками, температура на СД уходила за сотню, и даже удивительно, что линзы не плавились.

Я списал свою плазму именно по выгоранию, а не по моральному устареванию.

Ну фиг знает. В 2019м взял LG C65. С локдауна использую в качестве монитора. Соответственно, 8 часов в день на работу, потом ещё часов 5 телевизором. Т.е. тысяч 20 я нажёг уже точно. Остаточных изображений не видно. Общая яркость если и упала, то не сильно заметно. С другой стороны, работа — это в основном окно терминала с чёрным фоном и зелёными буквами на минимальной яркости.

Открою страшную тайну.... Все телевизоруы, даже жк сбрасывают яркость на всем экране... Даже хваленый кулед самсунг может иметь пиковую яркость 2000, а на весь экран будет 500 например и да, выгорание это уже как мем, в реальной жизни его нет

Есть монитор от делл, qdoled 34" гарантия на выгорание 3 года, в следующем году количество олед мониторов будет только рости, жк как не крути убогая и тупиковая технология, купил себе монитор на новой матрице 240гц, и все равно вижу гостинг... Про отсутствие черного я вообще молчу

Существуют референсные ЖК мониторы для производства HDR контента - они умеют в большую яркость по всей площади, и в хороший чёрный цвет - это достигается, насколько я знаю, локальным затемнением подсветки и двумя слоями ЖК кристаллов. Но это, понятное дело, не массовый продукт.

ну это понятно, но это все где то там... а мы где то тут))) а референсные мониторы еще и маленькие, то есть как телевизор они точно не пойдут. qdoled уже довольно яркие, так это всего лишь 1ая версия, будут улучшать, а тут еще и новую химия обещают для синего оледа, так что 2-3, ну может 5 лет и я думаю олед\кдолед просто уничтожит жк, у жк как не крути слишком много минусов

После калибровки LG вполне референс ща 30k $.

Это можно отключить у LG.

2-й год владею ноутбуком с OLED как рабочим, с экраном все отлично, яркость почти всегда (кроме ночи) где-то 75-80% (дальше ну уж слишком ярко само по себе).

AMOLED в LG уже морально устарел перед новым QD-LED. А там и настоящий QLED появится, без подсветки.

С телевизорами 4к и 120Гц все понятно.

У меня вопрос другой. А что вы на них собираетесь смотреть ? Где взять контент такого качества ? Ну игры - ладно а кино ?

Вот у меня была серия властелина колец. Качество ФХД, 10 бит на канал, 60Гц. Весила эта прелесть 86гигов. То есть на 1 блю рей диск не влезет! Но выглядит конечно шикарно и 10 бит реально видно в сравнении с 8 бит.

Теперь если мы возьмем тоже самое в 4к и сохраним кол-во информации на пиксель (то есть, не апскиленное фуфло), то это будет весить 86*4 = 344 гига!

На каком носителе или по какому интернету вы это собираетесь передавать ? А если оно будет 120Гц ? продавать фильмы на жестком диске ? Пологаю что для кинотеатров так и делают.

Или всю круть этих телевизоров можно посмотреть только на 5 минутной демке от производителя ?

Ну, во-первых, я тут ставлю акцент именно на использование ТВ как монитора - там контентом выступает, собственно, рабочий стол.

Во-вторых, что касается контента - это длинная отдельная тема, если в кратце, самое главное - при просмотре видео уже можно пользоваться уплавнялками, та задержка, которую они добавят, никак не повлияет. Автоматом всё, что 30 Гц, станет 120 Гц (хотя иногда это может нарушить художественный замысел). Плюс, есть разные кодеки и разный битрейт - например, H265 сжимает гораздо лучше. В онлайн сервисах битрейт обычно гораздо ниже, чем в блю-рей качестве, и достаточно иметь интернет-соединение в 150-200 Мбит/с.

В целом, история повторяется, как с FullHD - когда он появился, фильмы 20-40 Гб тоже казались чем-то немыслимым, у людей ещё было "2 рубля за мегабайт" и 5 Мбит/с. А потом постепенно пошло. Так и тут - повсеместное распространение (мобильного) интернета 500 МБит/с, новые кодеки, в которых фильм будет весить не 344 Гб а 100 Гб, нейросетевой апксейл (который в телевизоры, к слову, уже ставят), который умеет додумывать и дорисовывать детали, станет работать ещё лучше, накопители будут измеряться десятками терабайт, и т.п.

Сейчас я вижу что накопители наоборот отмирают. Блю рей, по сути, остался как нишевой сегмент для ценителей. А то что онлайн стрим оно маленькое и ужатое по самые помидоры чтоб не тормозило из-за плохого трафика там о качестве вобще речи нет можно смело смотреть на аналоговом телевизоре.

Получается что сейчас качественный телек - только ради игр. Апскилы и уплавнялки - это полное фуфло извините за мой французский, информации к контенту они не добавят.

Фильмов на жестких дисках в продаже я пока не видел даже для богачей - ценителей. Блю рей приводы есть у единиц.

Что будем смотреть на этих супер телеках? Пока появятся новые носители или супер пупер интернет, эти все телеки давно сдохнут по естественным причинам.

Всё это можно было точно так же сказать про FullHD в 2007 году.

По накопителям - если (вряд ли, конечно) появится лазерный диск за 400 рублей ёмкостью 100-200 Тб, то запросто могут вернуться. Но наиболее вероятно повсеместное распространение быстрого интернета. Онлайн сервисы, на мой взгляд, постепенно качество будут поднимать:

Даже пережатое видео в 10 бит лучше выглядит, чем 8 бит при том же битрейте

Кодеки появляются новые, и жмут лучше. Уже H266 делают.

Интернет становится быстрее

Нейросети всё лучше и лучше подавляют артефакты сжатия

Я говорил не про обычный апскейл, а про нейросетевой - он как раз добавляет информацию - сам её выдумывает. Другое дело, что на текущем этапе эта технология работает весьма посредственно, но не-реалтайм сети для апскейла уже сейчас демонстрируют впечатляющие результаты. В играх, кстати, уже повсеместно используют DSR - это оказывается быстрее, чем рендерить в полном разрешении.

На мой взгляд, важен ещё один нюанс - то, что сейчас называют "метавселенными", будет требовать очень быстрого интернет соединения и высокой эффективности сжатия контента, и, тем самым, упрощать жизнь для тяжелого видео.

В 2007 с носителями все было в порядке. Сейчас - наоборот.

Цикл жизни телевизора сейчас никакой. Подсветка дохнет через 2 года а олед - выгорает. Пока появится метавселенная и новые технологии передачи данных, нынешние телеки давно умрут, надо будет покупать новые, возможно, совсем другие и вовсе не телеки.

Так что нынешние разрешения и герцы это пока только для геймеров ИМХО.

щаз еще любители проекторов своё фи вставят..

Успокойтесь, я уже сдесь :)

И дело тут в том, что качественный контент даже для ФХД проектора найти не так просто...

Пока мейнстрим это 2х слойные блюрей. Но никакими 4к там и близко не пахнет...

Тут ниже верно пишут. В онлайне до 20 гиг в блюрей до 50 и пока это предел. Описанный мной выше фильм на 86 гиг это 2 2х слойных блюрей диска. Это исключение из правил.

Я правильно понимаю, что проблема, на которую Вы указывается, заключается в сложности достать качественный 4K контент?

Да какие там нафиг 4к ???

Даже ФХД качественный контент достать не так просто. Вы попробуйте! И чтоб это было не формально ФХД (шоу танцующих квадратиков или мыло), а реально качественный контент.

Если не квадратики, то рябь кинопленки. Те самые "шикарные 70мм" как говорил один известный режиссер чтоб было видно...

Пахнет. Все современные релизы делают из 6K мастера.

Так ведь вы телефон меняете каждый год, до того как он выгорет? В чем разница. Никто же не покупает LCD смартфоны.

Телефоны бывают и по 10тр, и ими даже можно пользоваться. А на ТВ за 10-20тр без слёз не глянешь, нормальные от 100тр. И это действительно нерациональное использование природных ресурсов, каждые несколько лет выбрасывать огромный ТВ на помойку. Опыт наших предков был более практичен и экологичен, когда вещь служила десятилетиями и передавалась детям и внукам.

К слову, Funai 93 года до сих пор показывает как новый. Эпоха качества, когда ещё не совали в каждый утюг преднамеренное устаревание.

Телефон за 10k не будет иметь даже VoLTE, я уж не говорю про 5G нашей частоты. Себестоимость этого тв за 100k где-то 5 тыс. Все остальное идет на R&D Mediatek, LG и др.

"Funai 93 года до сих пор показывает как новый"

У меня ТВ это монитор с HDR. Так что лол. И вообще он цифру хоть поддерживает? Нет. А аналог уже нигде почти нет, разве что у Ростелекома да акадо.

Нормально эта технология работает.

1)я смотрю как апскейлят нейросети и результат мне нравится. Надо только подождать пока это дойдёт до реалтайма в телевизоре.

2)уплавлялки это необходимость в современном кино. Когда сидишь в метре перед 49" экраном, а на нём крутят 24гц кино, то при движени всего фона это выглядит как набор фотографий, а не как плавное движение.

А зачем сидеть в метре перед 49" экраном (или зачем 49" экран, если сидишь в метре)? Правило 3-4 диагоналей вроде никто не отменял.

Мб потому что смысл не только в диагонали, но и в разрешении?

Так большие разрешения имеют смысл при больших диагоналях, а если сидеть в метре - FullHD хватит за глаза.

затем что 49" экран в метре от меня обеспечивает идеальный угловой размер экрана. В играх большой обзор, в фильмах возможность рассмотреть и происходящее на заднем плане.

Я хз кто придумал этот бред про 3-4 диагонали экрана. Вероятно корни идут откуда-то из древности. Например от малого разрешения экрана, когда если сидеть слишком близко пиксели становились размером с кулак. Но даже на 42" fhd я садился в полутора метрах. но это да, уже компромис между крупными пикселями и большим экраном.

А зачем сидеть в метре перед 49" экраном (или зачем 49" экран, если сидишь в метре)? Правило 3-4 диагоналей вроде никто не отменял.Отменено, когда появилось высокое разрешение.

Иначе зачем оно нужно, если не видно разницы:

Так это уже придется глазами по экрану бегать, целиком не охватить взглядом. Я от 49" сижу в 3 метрах и мне все равно хочется отодвинуться подальше (но уже некуда).

Так это уже придется глазами по экрану бегать, целиком не охватить взглядом.Угу, это создает «эффект присутствия», когда изображение выходит за пределы центрального зрения, практически на границы периферийного (а в идеале и за них).

При этом мы наблюдаем за событиями не «через окно», а находясь внутри

Я от 49" сижу в 3 метрахну, можно и от 14" сидеть в 3 метрах. Хозяин — барин.

и мне все равно хочется отодвинуться подальшеЕсли смотрите телевизионную картинку с лицом на полэкрана, или старые телефильмы, адаптированные под низкое разрешение, в основном с крупными планами.

Но если смотреть кинофильм (пусть даже и старый, но снятый под киноэкран), и тем более современные версии, где даже при диалогах не бывает морд лица во весь экран, а события происходят по всему кадру, скорее возникает желание поближе придвинутся.

Ну и опять-таки — «эффект присутствия», не ограниченный рамками.

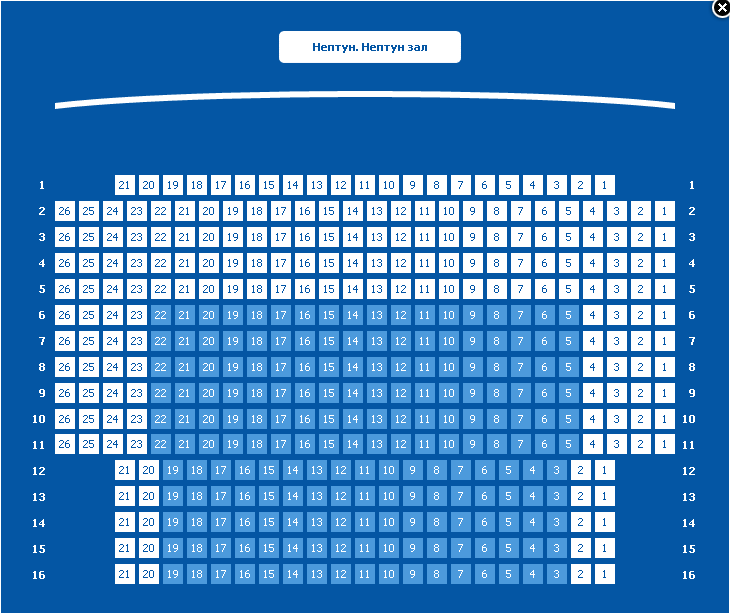

Кстати, о кинотеатрах — Планировка кинозала «Нептун»:

Cамые комфортные места как раз на расстоянии порядка диагонали.

У людей может быть проблемы со зрением.

2) происходит из-за слишком быстрого отклика OLED.

Потому что все blu-ray на kinozal выкладавают, а еще потому что Dolby Vision профиль 5 лучше.

О чем вы? Какие 150-200? Это даже больше битрейта бд 4к...в онлайне там обычно 20мб максимум)

Да и объективно, нет контента 4к, точнее есть, но крайне мало. 90% фильмов апскейл с 1080, ну иногда с 2к. Даже фильмы мервел, у которой бабла немерено это апскейл. Их достатояно записывать в 1080шдр и все, но модно же 4к... Вот и растягивают

Есть конечно исключения из правил. Например терминатор 2 в 4к намноно лучше 1080, но таких примеров мало, чаще всего получаешь тоже самое мыло, но с шдр, а иногда 4к даже хуже оригинала. Пример матрица... Где в 4к убрали художественный замысел, убрав зеленый фильтр, ну е мое....

А если оно будет 120Гц

Проблема чисто теоретическая, таких фильмов не снимают пока.

10 бит на канал? Это, вероятно, из той же оперы как и усилитель ЗЧ с полосой до 200 кГц. Круто, понтово, но вряд ли ухо услышит выше 10-15 кГц. Помнится на курсах по телевидению нам говорили, что разрешение глаза по яркости не превышает 7 бит, т. е. более 128 градаций он различить чисто физически не в состоянии. По цветности разрешение глаза еще хуже примерно в 4-5 раз.

Вы сможете различить и 12 бит на канал, правда, дисплеев таких пока нет. Обратите внимание, что речь идёт о диапазоне интенсивности света и цвета, которую способен воспринять человек, и диапазон этот весьма и весьма высок.

По аналогии с изображением, это будет не увеличение разрешения одной и той же картинки, а увеличение разрешения и угла обзора (панорамности). Если мы увеличиваем угол обзора, то увеличивается количество объектов, попадающих в кадр, и для сохранения уровня деталлизации нам нужно повысить разрешение.

Так и тут. Первые 8 бит расходуются на обычный диапазон яркости от 0 до 100%, а дополнительные два - от 100% до 1000%. И глаз это видит.

Под каналом вы подразумеваете отдельные каналы R, G и B? Если так, то еще раз повторюсь: разрешение глаза по яркости не превышает 7 бит, эти исследования проведены давным давно еще на заре телевидения. Подавать на глаз бОльший диапазон - нет смысла. Вы только будете перенапрягать адаптационную систему глаза к разной яркости. Глаз будет пытаться рассмотреть темные элементы, расширяя зрачок и офигевать от ярких вспышек, рефлекторно сужая зрачок. Больше информации чем содержится в 7 битах или 128 градациях вы передать все равно не сможете, как бы вы не старались. Остальное все маркетинг. По цвету разрешение еще хуже.

Тут суть в том, что обычно используются sRGB - это перевод RGB в рабочие цвета монитора, передаётся на моник как RGB(ну, по крайней мере картой). А так то есть много различных RGB типов.

Что подразумевается под разрешением глаза?

Вы не учли, что у глаза подстройка яркости осуществляется не только изменением зрачка, но и подстройкой чувствительности палочек и колбочек. Только, в отличие от камер, у глаза чувствительность регулируется отдельно для каждого "пикселя". И, даже если 7 бит достаточно (интересно было бы почитать подробнее), то при разной экспозиции эти 7 бит будут распределяться по разным физическим диапазонам.

Условно говоря, вот у нас рядом два "пикселя" сетчатки. У одного чувствительность настроилась на диапазон 0 - 100 кд/м², а у соседнего - на 0 - 10000 кд/м². С каждого из них, грубо говоря, в мозг идет информация не только об этих 7 битах, но и об уровне чувствительности, который выставлен у конкретного "пикселя". И мозг 7 бит будет умножать на коэффициент чувствительности, восстанавливая исходную картинку в сознании с большим диапазоном яркости.

Телевизор не знает, какой пиксель на его матрице с какой палочкой или колбочкой глаза совпадёт при просмотре. Поэтому, ему приходится рулить всем диапазоном сразу - от 0 до 10000 кд/м² (правда, сейчас обычно до 2000). А для хранения диапазона от 0 до 10000 кд/м² без резких скачков как раз нужно больше 8 бит, даже с учётом нелинейности глаза (поэтому в HDR гамма не обычная, а гибридная).

Я подозреваю, что исследования про 7 бит как раз учитывают именно разрешение по интенсивности без учёта возможностей автоподстройки чувствительности отдельных палочек и колбочек.

Проблемы с перегрузкой у глаза начинаются с яркости в 100 000 кд/м², что пока очень далеко от возможностей современных экранов.

Попробуйте взглянуть на настоящий HDR на хороших современных экранах. Вы увидите разницу невооружённым взглядом.

что у глаза подстройка яркости осуществляется не только изменением зрачка, но и подстройкой чувствительности палочек и колбочек

Первый раз слышу о таком чуде. Не поделитесь ссылочкой, где вы прочитали об этом?

(интересно было бы почитать подробнее)

Любой учебник по телевидению, рекомендую Джаконию, стр. 35-36

то при разной экспозиции эти 7 бит будут распределяться по разным физическим диапазонам

Именно так и происходит. Но количество передаваемой зрительной информации, выраженной в градациях яркости - тем не менее не меняется - как были 7 бит, так и остаются.

два "пикселя" сетчатки. У одного чувствительность настроилась на диапазон 0 - 100 кд/м², а у соседнего - на 0 - 10000 кд/м².

Еще раз, впервые слышу о таких чудесах. Такое невозможно даже теоретически. Это как заявить что у человека одна часть кожи распознает температуру от -20 до +60 С, а другая от -20 до +6000 С. Соответственно, все ваши дальнейшие рассуждения на основании этого крайне сомнительного утверждения также сомнительны.

А ещё ходят слухи, что рецепторы глаза умеют ползать.

Любой учебник по телевидению, рекомендую Джаконию, стр. 35-36

Спасибо.

Ок, зафиксируем: мой тезис о том, что человек видит 10 бит и 12 бит, основывается на утверждении, что разные рецепторы на сетчатке глаза могут быть настроены на разную чувствительность в один момент времени, и эта дополнительная информация об их настройке чувствительности тоже попадает в мозг. По этой же причине яркие объекты "отпечатываются" на сетчатке и "висят" на изображении ещё некоторое время после того, как само воздействие пропадёт.

Если вкратце - интенсивное воздействие света на рецептор расщепляет в нём то вещество, которое, собственно, ответственно за чувствительность, поэтому чувствительность конкретно этого рецептора постепенно снижается. Если воздействие света убрать - вещество постепенно восстанавливается. Этот фотохимический процесс происходит в каждом рецепторе независимо. В гугле можно найти много всего (раз, два, три, например).

Адаптация фоторецепторов - это не привилегия глаза. Так делают почти все рецепторы в нашем организме.

Это как заявить что у человека одна часть кожи распознает температуру от -20 до +60 С, а другая от -20 до +6000 С. Соответственно, все ваши дальнейшие рассуждения на основании этого крайне сомнительного утверждения также сомнительны.

Данная аналогия неверна, потому что восприятие температуры у человека

а) почти линейно

б) лежит в весьма узком диапазоне - условно говоря, от -60 до 60 С

Яркость же воспринимается человеком не линейно, а по логарифмической шкале, и воспринимается в очень большом диапазоне - от почти 0 кд/м² (ходят споры о способности человека различать отдельные фотоны, но лягушки так умеют - доказано) до 1000 000 000 кд/м² (!), но, справедливости ради, всё, что ярче 100 тысяч кд/м² вызывает боль. Кд/м², в данном случае, не совсем правильная единица измерения, но представим, что речь о мониторе на расстоянии 2 метра.

Кожа тоже может иметь разную чувствительность. Есть классический эксперимент: берете стакан горячей воды, стакан холодной воды и стакан с обычной водой. Палец одной руки окунаете в стакан горячей воды, палец другой руки окунаете в стакан холодной воды и держите так 1 минуту. Затем одновременно окунаете пальцы в стакан с нейтральной водой. Одному пальцу будет холодно, второму тепло. Потому что у рецепторов сместился диапазон измерений - они адаптировались.

Боюсь, вы путаете разные вещи. Действительно, у глаза есть много механизмов адаптации к разной освещенности - изменение диаметра зрачка, перемещение черного пигмента в слоях сетчатки, снижение чувствительности. Но все эти механизмы - медленные, особенно фотохимические (десятки секунд, минуты). Эти механизмы не предназначены для "оперативной" и быстрой реакции и получения из этой реакции информации. Это защитные механизмы, необходимые для удержания светового потока в пределах динамического диапазона датчика, сам этот диапазон при этом не меняется (те же 92 градации).

И в приведенных вами ссылках указана лишь общеизвестная информация по адаптации глаза, которая сомнений не вызывает. Я просил привести мне статьи или исследования, где указывается что подобные механизмы позволяют расширить динамический диапазон восприятия .

Приведя эти статьи вы противоречите сами себе, ведь вы утверждали:

У одного чувствительность настроилась на диапазон 0 - 100 кд/м², а у соседнего - на 0 - 10000 кд/м²

Вы говорили, что чувствительность настраивается мозгом, а в статьях пишут что все таки - светом. И как тогда может одна палочка настроиться так, а другая иначе, если общая освещенность у них у всех одинакова и определяется текущим раскрывом зрачка и текущим фотохимическим состоянием.

мой тезис о том, что человек видит 10 бит и 12 бит, основывается на утверждении, что разные рецепторы на сетчатке глаза могут быть настроены на разную чувствительность в один момент времени, и эта дополнительная информация об их настройке чувствительности тоже попадает в мозг.

И все таки, вы этот тезис сами придумали или где то прочитали? Все еще хочу увидеть ссылку на эту статью.

Яркость же воспринимается человеком не линейно, а по логарифмической шкале, и воспринимается в очень большом диапазоне - от почти 0 кд/м² (ходят споры о способности человека различать отдельные фотоны, но лягушки так умеют - доказано) до 1000 000 000 кд/м² (!), но, справедливости ради, всё, что ярче 100 тысяч кд/м² вызывает боль. Кд/м², в данном случае, не совсем правильная единица измерения, но представим, что речь о мониторе на расстоянии 2 метра.

Вы намеренно или нет, но подменяете понятия чувствительности палочки и всего глаза целиком. Надеюсь, что вы все же не пытаетесь ввести в заблуждение читателей, а добросовестно заблуждаетесь. Да, диапазон чувствительности глаза огромен, но это именно глаза - со всеми элементами защиты и регулировки светового потока. Одновременно смотреть на солнце и различать отдельные фотоны глаз НЕ МОЖЕТ! Если вам трудно это понять, то предлагаю аналогию с фотоаппаратом и его диафрагмой. У фотопленки есть определенный диапазон чувствительности (допустим, те самые 7 бит как у глаза). С помощью диафрагмы (зрачка) мы изменяем интенсивность светового потока так, чтобы все яркостные точки картинки, и самая слабая и самая сильная - уложились в этот диапазон. От положения самой диафрагмы - мы НЕ СМОЖЕМ извлечь никакой новой информации из изображения, кроме ее общей освещенности, которую мы и так получаем от самого изображения на фотопленке. Если у фотопленки чувствительность от 0 до 127, то НИКАКИМИ другими способами мы не сможем ее сделать от 0 до 256 или до 512, хоть ты тресни.

Вы говорили, что чувствительность настраивается мозгом, а в статьях пишут что все таки - светом. И как тогда может одна палочка настроиться так, а другая иначе, если общая освещенность у них у всех одинакова и определяется текущим раскрывом зрачка и текущим фотохимическим состоянием.

Надеюсь, Вы ненамеренно исказили смысл моих слов. Я писал о том, что

разные рецепторы на сетчатке глаза могут быть настроены на разную чувствительность в один момент времени, и эта дополнительная информация об их настройке чувствительности тоже попадает в мозг

Здесь нет ничего о том, что их настраивает мозг. Они подстраиваются сами, мозг просто получает информацию об этом. Более того, освещенность у них неодинаковая, потому что на них попадает разное количество света от разных частей проецируемой через хрусталик картинки.

Одновременно смотреть на солнце и различать отдельные фотоны глаз НЕ МОЖЕТ!

Вы сами выдвинули это утверждение, и сами же его опровергли. Я не говорил о том, что глаз одновременно может видеть солнце и видеть отдельные фотоны.

Если вам трудно это понять, то предлагаю аналогию с фотоаппаратом и его диафрагмой. У фотопленки есть определенный диапазон чувствительности (допустим, те самые 7 бит как у глаза). С помощью диафрагмы (зрачка) мы изменяем интенсивность светового потока так, чтобы все яркостные точки картинки, и самая слабая и самая сильная - уложились в этот диапазон. От положения самой диафрагмы - мы НЕ СМОЖЕМ извлечь никакой новой информации из изображения, кроме ее общей освещенности, которую мы и так получаем от самого изображения на фотопленке. Если у фотопленки чувствительность от 0 до 127, то НИКАКИМИ другими способами мы не сможем ее сделать от 0 до 256 или до 512, хоть ты тресни.

На всякий случай повторюсь

мой тезис о том, что человек видит 10 бит и 12 бит, основывается на утверждении, что разные рецепторы на сетчатке глаза могут быть настроены на разную чувствительность в один момент времени, и эта дополнительная информация об их настройке чувствительности тоже попадает в мозг.

То есть, если бы глаз имел одинаковую по всей сетчатке чувствительность, то тогда бы Ваша аналогия с камерой была бы верна.

Попробуйте в солнечный день посмотреть на автомобиль, половина которого находится в тени, а вторая на солнце. Вы одновременно сможете разглядеть обе половины. Однако, часть, находящаяся на солнце, может быть в 10 и более раз ярче той, которая находится в тени. Эту яркость можно измерить специальными приборами, это вполне известный факт.

Если бы, как Вы утверждаете, наш глаз имел столь узкий диапазон чувствительности, мы бы либо могли видеть то, что в тени, а остальное было бы засвечено, либо видели бы только то, что на солнце, а остальное бы представлялось нам, как темнота. Так происходит у обычных камер, но не у глаза.

Вы можете самостоятельно измерить прибором яркость разных объектов на улице в солнечный день, и убедиться, что Ваш глаз увидит их одновременно, и при этом их яркость будет отличаться на порядок.

Но, поскольку это не так, и глаз может регулировать чувствительность отдельных рецепторов, Ваша аналогия не является верной.

и эта дополнительная информация об их настройке чувствительности тоже попадает в мозг.

Нет, не попадает. Это чисто химическая адаптация — там есть обратная связь по количеству импульсов и в темноте увеличивается синтез фоточувствительных пигментов, а на свету — уменьшается, и они через некоторое время распадаются. Мозг это не контролирует.

Проблема в том, что в мозге и так происходит большая часть удаления шумов, псторойка фузии, считывание разницы между звука по кости и от левого правого ухо для расчета источника звука, и адаптация на цвет и свет.

И апскейл тоже, если у вас плохое зрение.

могут быть настроены на разную чувствительность

Так все таки, кто их настраивает? И каким образом эта информация попадает в мозг? От глаза второго нерва в мозг не идет. Как они могут подстраиваться сами? В той же статье говорится, что они только могут войти в насыщение (ослепление) и для выхода из насыщения необходимо до нескольких минут времени.

Если бы, как Вы утверждаете, наш глаз имел столь узкий диапазон чувствительности, мы бы либо могли видеть то, что в тени, а остальное было бы засвечено, либо видели бы только то, что на солнце, а остальное бы представлялось нам, как темнота.

Я говорил про чувствительность по яркости. Но колбочки имеют намного меньшую чувствительность и когда палочки, допустим, входят в насыщение, колбочки продолжают работать. Именно поэтому ночью вы различаете только свет, но не цвет. Поэтому в вашем примере темная сторона различается палочками, я яркая — колбочками. Но, во первых, колбочек намного меньше, поэтому и различимая детализация будет меньше, а во вторых, в темной части вы также не различите больше 3-4 градаций из-за насыщения, остальную недостающую информацию мозг дофантазирует. Поэтому говорить о полноценном восприятии также не имеет смысла.

И опять вы путаете глаз и сетчатку. Глаз не может регулировать чувствительность рецепторов, это невозможно, таких механизмов нет.

Динамическая чувствительность человеческого глаза - около 24 стопов, динамическая же < 12 стопов, и с возрастом и потерей зрения сильно уменьшается. Поэтому некоторым людям 10 кратный перепад яркости в пределах четкого угла зрения уже может мешать ясно видеть детали.

Вот ей богу, у вас столько отсебятины написано в материале, надерганной по верхам, не имеющей ничего общего с реальностью. Не понимаю, если вы в этом не разбираетесь, зачем лезите ещё кого-то учить разбираться в современных технологиях вывода изображения? Только маркетологам помогаете дальше свой хлеб есть.

Если у фотопленки чувствительность от 0 до 127, то НИКАКИМИ другими способами мы не сможем ее сделать от 0 до 256 или до 512, хоть ты тресни.

Простите, но Вы заблуждаетесь. При этом пишете с абсолютно необоснованным, на мой взгляд, апломбом.

Если у нас рецепторы имеют линейную чувствительность от 0 до 127 (для человеческого глаза это не так, но сначала рассмотрим техническую модель с такими параметрами), то есть несколько механизмов увеличение чувствительности.

Первый — посредством нескольких экспозиций с разным уровнем светового потока (он регулируется длительностью экспозиции, фильтрами, шириной диафрагмы). То есть если вы сделаете четыре снимка, на каждом из которых диапазон будет 0...127, но с разным уровнем светового потока, то у вас получится диапазон 0...127 + 128...255 + 256...383 + 384...511 = 0...511.

Второй — учет различий между сенсорами. Хоть каждый из сенсоров и различает 128 градаций, но эти градации у них не одинаковы. Скажем, один сенсор имеет 128 градаций с шагом 1 0...127, второй также с шагом 1 0,25...127,25, третий также с шагом 1 0,5...127,5 и аналогично четвёртый 0,75...127,75. Совместно они дадут интервал 0...127,75 с шагом 0,25. Приводя к единичному шагу, получим 0...511 с шагом 1. К этому можно добавить возможность делать несколько снимков с разным смещением образа изображения на сенсорах.

Теперь возвращаемся от технических систем к человеческому зрению.

Я на всякий случай перепроверил учебник «Телевидение» под редакцией В. Е. Джаконии. Там, конечно, нет таких безапелляционных заявлений, будто зрительная система человека принципиально не способна различить более 128 градаций серого. Там, напротив, написано достаточно обтекаемо.

Она, разумеется, способна. Это проявляется в первую очередь в динамике — при фейдинге нескольких немного отличающихся оттенков разница на реальных дисплеях заметна. Усугубляется это тем, что градации у человеческого глаза сильно нелинейны, и они не совпадают с градациями, которые дают восьмибитные видеосистемы.

Про яркие точки, вызывающие сужение зрачка, локальное расходование пурпура и даже болевые ощущения Вам уже сказали. Это всё эффекты, которые зрительная система человека воспринимает, и которые обычные восьмибитные дисплеи вызывать не способны.

Ситуация усугубляется также тем, что в современном мире дискретизаций множество. Например, если вы смотрите на видео, где показывают экран монитора, то у вас дискретность исходного монитора накладывается на дискретность сенсора камеры и на дискретность конечного монитора. И это может давать не то что различимые глазом, а даже и очень сильно бросающиеся в глаза артефакты.

Больше информации чем содержится в 7 битах или 128 градациях вы передать все равно не сможете, как бы вы не старались. Остальное все маркетинг.

Так что это Ваше заявление — это просто Ваша недостаточная компетентность. Вы слышали звон на лекции, но не осознали границ применимости этого звона. Я бы не стал так резко писать, разумеется, если бы Вы не писали с таким апломбом.

Если у нас рецепторы имеют линейную чувствительность от 0 до 127 (для человеческого глаза это не так,

Почему вы все путаете глаз (оптическая система в сборе) и сетчатку (отдельные рецепторы)? И мешаете чевствительность глаза (как сложной системы с кучей механизмов по регулировке светового потока и чувствительности) с чувствительностью палочки (как одного рецептора)? Да еще делаете это абсолютно необоснованным апломбом.

Все ваши примеры некорректны и к увеличению чувствительности никакого отношения не имеют.

1. Да, так можно сделать, но в реальности это костыль. Каждые отдельные снимки так и останутся с разрешением 0...127. Вы получаете на их основе больше оптической информации не за счет качества, а за счет количества. Чтобы их свести в один необходима дополнительная обработка этих снимков с весьма сложными алгоритмами. Глаз, разумеется, так не делает и не может делать. В каждый конкретный момент он считывает только одну картинку. Оперативно управлять диафрагмой (зрачком) он не может, это медленный механический процесс, остальные способы еще медленнее, так как они фотохимические.

2. Ну, это уже ваши фантазии

3. Учебник вы читали невнимательно, хотя я указал конкретные страницы. В учебнике заявляетя о 92 градациях. Соответственно, диапазон 0...127 или 7 бит его с лихвой перекрывает. Ничего обтекаемого там нет, там формулы и цифры. Прочтите учебник еще раз.

4.

Усугубляется это тем, что градации у человеческого глаза сильно нелинейны, и они не совпадают с градациями, которые дают восьмибитные видеосистемы.

Вы опять путаете теплое с мягким. Какое отношение какие то там 8битные системы имеют к человеческому зрению? Кто делал эти системы? С чего вы взяли что их 8 бит по градациям соответствуют «8 бит» градациям глаза? Возможно, их 8 бит укладываются в 3-4 «бита» глазных, или наоборот? Почему вы так лихо ставите знаки равенства между двумя совершенно разными системами и еще умудряетесь делать из этого какие то выводы и поучать?

Это всё эффекты, которые зрительная система человека воспринимает, и которые обычные восьмибитные дисплеи вызывать не способны.

Не только 8битные, но и любые другие. Это все медленные механические и фотохимические реакции. Монитор вообще не должен на них влиять. Если монитор будет заставлять зрачок ежесекундно дергаться, вынуждать химические процессы идти туда-сюда, не нужно иметь 7 пядей во лбу чтобы понять, что это нифига не полезно для зрения.

Ваша компетенция тоже вызывает большие вопросы, можете не обольщаться насчет этого. Кроме необоснованных «маркетинговых» сентенций, никаких доводов от вас я не услышал.

Почему вы все путаете глаз (оптическая система в сборе) и сетчатку (отдельные рецепторы)?

Это Вы путаете. Я чётко разграничиваю отдельные рецепторы и зрительную систему человека. Перечитайте мой комментарий, пожалуйста, и убедитесь в этом.

Все ваши примеры некорректны и к увеличению чувствительности никакого отношения не имеют.

Разумеется, имеют. Эти методы активно применяются для того, чтобы улучшать качество изображения в технических системах.

Да, так можно сделать, но в реальности это костыль. Каждые отдельные снимки так и останутся с разрешением 0...127. Вы получаете на их основе больше оптической информации не за счет качества, а за счет количества. Чтобы их свести в один необходима дополнительная обработка этих снимков с весьма сложными алгоритмами.

Вообще-то там было про технические системы, я об этом чётко написал. Но и в отношении человека у меня для Вас есть хорошая новость: зрительная система человека — это не только глаз, но и мозг, который как раз обрабатывает получаемую от рецепторов информацию весьма сложными алгоритмами. Зрительная кора — одна из самых сложных структур мозга.

2. Ну, это уже ваши фантазии

А, ну да, конечно, если Вы не в курсе, значит, фантазии, конечно. На этом я заканчиваю обсуждение. Допишу этот комментарий, и всё.

3. Учебник вы читали невнимательно, хотя я указал конкретные страницы. В учебнике заявляетя о 92 градациях. Соответственно, диапазон 0...127 или 7 бит его с лихвой перекрывает. Ничего обтекаемого там нет, там формулы и цифры. Прочтите учебник еще раз.

Не считайте себя самым умным, а окружающих — дебилами.

Разумеется, я видел это число 92, и прочитал, как оно получено.

Я даже процитирую фразу из учебника: «Полагая, что максимальный контраст, ограничиваемый глазом, Lmax/Lmin = 100, a sigma = 0,05, получаем, что максимальное число градаций, которое глаз будет различать при данных условиях, A ~= 92».

Вы не поняли, что параметры 100 и 0,05 — достаточно условные (хотя, казалось бы, то, что они такие круглые должно было Вам на это намекнуть), и даже слова «при данных условиях», к сожалению, не помогли Вам это понять.

В учебнике нет того максимализма, который демонстрируете Вы.

Так что это Вам нужно читать учебник.

Вы опять путаете теплое с мягким. Какое отношение какие то там 8битные системы имеют к человеческому зрению? Кто делал эти системы?

Это вы опять не поняли написанного, а туда же — с апломбом писать про путаницу. Ничего я не путаю. Под восьмибитными системами подразумеваются те, у которых на компоненты R, G и B выделено по восемь бит — те, которых, как Вы ошибочно утверждаете, якобы хватит всем, а больше — это якобы только маркетинг.

С чего вы взяли что их 8 бит по градациям соответствуют «8 бит» градациям глаза? Возможно, их 8 бит укладываются в 3-4 «бита» глазных, или наоборот?

Ну так это Вы «взяли», а не я. Вы же заявили, что 10-битный и тем более 12-битный HDR нинужон, что это один только сплошной маркетинг.

Но если восемь бит градаций современных мониторов — это «не те» восемь бит градаций глаза, то может двенадцать бит «не тех» градаций таки нужная вещь, которая помогает мониторам удовлетворять «тем» градациям? Подумайте об этом, пожалуйста.

Не только 8битные, но и любые другие. Это все медленные механические и фотохимические реакции. Монитор вообще не должен на них влиять.

С чего бы это монитор не должен на это влиять, если ставится задача приблизиться к реальности? А если задача приблизиться к реальности не ставится, то и шестнадцати градаций (четырёх бит) достаточно для большинства практических задач.

По поводу здоровья — животные эволюционировали в условиях реальности, в которой динамический диапазон колебаний освещённости весьма велик. Но в любом случае, Вы как-то незаметно переходите от принципиальной невозможности к заботе о здоровье, несмотря на принципиальную возможность.

никаких доводов от вас я не услышал

Это Ваша проблема, что Вы не слышите то, что не соответствует Вашей точке зрения. Не вижу смысла с Вами дискутировать — выхлоп этой дискуссии в любом случае будет близким к нулю. Лучше постараюсь статейку набросать про предельные возможности зрительной системы человека. Не знаю, правда, когда руки дойдут.

Полагая, что максимальный контраст, ограничиваемый глазом, Lmax/Lmin = 100, a sigma = 0,05, получаем, что максимальное число градаций, которое глаз будет различать при данных условиях, A ~= 92Да, меня это тоже позабавило. Притянули за уши непонятно откуда взятые числа, без всяких объяснений, причем, такое впечатление, что из какой-то очень древней методички

Такое впечатление, что авторы пытаются подогнать человеческое зрение под несовершенство техники

По поводу той же сигмы там же на предыдущей странице написано:

«В рабочем диапазоне изменения яркости фона (яркости адаптации) Lф в первом приближении можно считать, что (deltaL/Lф)пор = sigma = 0,02...0,005 = const.»

Используемое при получении A = 92 значение sigma 0,05 далеко от концов диапазона, про который они осторожно пишут «в первом приближении». А ведь ещё и размер деталей имеет значение, на что авторы также указывают.

Если, к примеру, взять sigma = 0,005 (с конца диапазона «в первом приближении»), то получится A ~= 921, что влезет уже только в 10 бит, почти совсем без запаса.

Для удобства давайте приведём всю выдержку текста про контраст

Страницы 40-43 включительно

У вас даже мысли не возникло, что это опечатка? Когда указывают диапазон чисел, то слева обычно пишут меньшее число, а справа - большее. И это не говоря уже о том, что число 0,005 противоречит смыслу далее излагаемого текста. И более того, правильное число 0,05 приведено далее в расчете.

На данных страницах этот диапазон берётся как исходная точка рассуждений (причем, с оговоркой "при первом приближении"), принимается как данность, и на этой данности уже строятся остальные рассуждения. С этими рассуждениями всё более-менее понятно.

Мне же интересно было бы узнать само обоснование тезиса про дипазон 0,02...0,05. Я хотел бы где-нибудь прочитать, на основании каких рассуждений, расчётов и исследований был выведен данный диапазон. Это действительно прояснило бы многие вопросы.

У вас даже мысли не возникло, что это опечатка? Когда указывают диапазон чисел, то слева обычно пишут меньшее число, а справа - большее. И это не говоря уже о том, что число 0,005 противоречит смыслу далее излагаемого текста. И более того, правильное число 0,05 приведено далее в расчете.

Я не заметил, что там есть опечатки, спасибо, что обратили внимание.

Есть и быстрые эффекты, но они в мозге, это называется адаптация.

Фотопленка имеет разрешение 16 K. Там хоть 7 бит не проблема.

У нее нет пикселей. У зерна нет градаций по яркости

Есть. Называется атомы.

Но вопросов больше нет, это да

Предположу, что, возможно имеется ввиду, что у плёнки изображение тоже квантуется - не по пикселям, а по зёрнам, и при некоторых допущениях это можно считать эквивалентом разрешения.

А по градации - по идее, плёнка работает на фотохимии, и молекулы зерна могут либо прореагировать, либо не прореагировать, промежуточных состояний быть не может, поэтому, как-бы, уровень градации квантуется - сколько молекул на поверхности зерна прореагировало, а сколько - нет. Только уровней этих примерно столько, сколько молекул на поверхности зерна, поэтому таким квантованием можно пренебречь, кроме случаев проектирования плёночных камер для микродронов.

Это мои предположения, я не претендую на экспертизу.

Неравномерный засвет нескольких молекул происходит при экспонировании. При проявлении — каждое зерно дореагирует целиком, все сразу, без градаций

Очень интересно, не подскажите качественные источники, где можно про это почитать?

Неравномерный засвет нескольких молекул происходит при экспонировании. При проявлении — каждое зерно дореагирует целиком, все сразу, без градаций

Тогда это больше напоминает дизеринг, а не градацию в прямом понимании.

Уровни градации сюда, наверное, можно за уши притянуть, но это количество уровней будет не постоянно, а зависеть от площади участка, который мы рассматриваем - чем он больше, тем больше в нём зерен, тем больше вариантов градаций.

И разрешения тоже нет, потому что нет пикселей. А зерна — еще и разного размера в пределах одной эмульсии

Ещё как есть))

Почему, например, считается что слайд критичен к пересветам, а негатив к теням? Потому что на самой плёнке это будут прозрачные участки с вымытой фотоэмульсией. И сколько света (при печати, сканировании или проекции) не давай на эти участки - информации в них ноль. А вот наиболее плотные участки эмульсии в процессе проявки можно как раз "пробить".

P.S. "Зерно" - это что-то из сельского хозяйства? В фотохимии это просто слэнг для обозначения частиц серебра или пигмента.

ни при чом

Зерно — фактически, является общепринятым термином, а не жаргоном

Ну для начала мы про градации (разрешение - отдельная тема). Если их нет в тенях или светах - это та самая "битность". Ну т.е. наличие или отсутствие информации.

Зерно - это термин, обозначающий прежде всего что? Фактуру "пленочного изображения". Всё. А химия фотоэмульсионного слоя описывается в несколько иных терминах.

Ну что это за "зерно дореагирует", "у зерна нет градаций по яркости"?..

Ну так — придраться не вышло.

Ибо в контексте обсуждения — у пленки нет градаций. Там, как попытались сформулировать «на айтишном» в каментах — дизеринг зерном непостоянного размера

Зерно — это буквально: «зерно». Плотное и аморфное образование галогенида серебра или самого серебра. Самый подходящий и потому — общепринятый термин

Мне так реально надо разжовывать каждое слово? Я могу, даже с формулами, ибо за плечами изучение нескольких видов химии в мед универе — но нафига мне это делать? Тут айтишный ресурс, ни разу не химический и я не буду пытаться общаться с пользователями, как препод на лабе. Терминологии д76 ру более чем достаточно и для профессиональных фотолаборантов, мутящих свои составы, и для здешних айтишников

Так что, плиз, не надо этой викпедийной гуглоэрудиции

Ибо в контексте обсуждения — у пленки нет градаций.

Ну во-первых, у плёнки есть "градации". Не верите? Снимите на плёнку любую "серую шкалу"))

Во-вторых, в слайде, например, конечное изображение формирует отнюдь не коллоидное серебро, а специальные пигменты.

В-третьих, вы, видимо, как раз-таки очень плохо себе представляете "внутренности плёнки". Толщина фотоэмульсионного слоя довольно значительна - т.е. ваше зерно там расположено не только в плоскости плёнки, но и по "ярусам", да ещё довольно хаотично. А не как вы тут пытаетесь представить формирование плёночного изображения в виде растровой черно-белой печати))