Comments 11

Спасибо за статью. А не подскажите, для этого анализа нужна платная лицензия? На сколько большие логи? Для компании из 100 человек хватит 500Мб в день или какое там ограничение у бесплатной версии Splunk?

0

Несколько лет назад написали приложение Thirdlane Free Metrics для Splunk, парсит Asterisk queue_log и CDR, к сожалению популярностю не пользуеться, по непонятным мне причинам.

0

Правильно ли я понимаю что Splunk можно прикрутить к любой БД для аналитики данных?

И как на счет встраивоемости дашборда как виджета в существующие проекты?

И как на счет встраивоемости дашборда как виджета в существующие проекты?

0

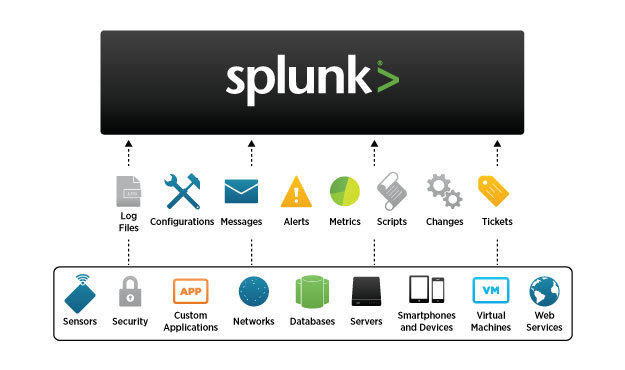

- Да, правильно. Но помимо БД он нас самом деле может забирать данные практически из любого источника.

Об этом мы писали здесь.

- Да, это тоже можно сделать.

0

Ну не знаю, товарищи, лучше для аналитика чем кастомный sql, пока не придумали, сколько систем не ставили всеровно в конце аналитики любят кастомные запросы подходят и озвучивают свои хотелки, и неодна готовая система еще может этого.

+1

Splunk это не коробочное решение с уже зашитой аналитикой, это скорее инструмент для анализа данных. Он как раз и позволяет реализовать все хотелки аналитиков, посредством своего языка запросов SPL. Посмотрите наши предыдущие статьи, они как раз про SPL, и все станет несколько прозрачнее.

И если в данной статье мы говорим про CDR и так или иначе структурированные данные, то сравнение с sql конечно возможно. Но если мы перейдем в пространство неструктурированных данных, то для sql все становиться намного сложнее.

И если в данной статье мы говорим про CDR и так или иначе структурированные данные, то сравнение с sql конечно возможно. Но если мы перейдем в пространство неструктурированных данных, то для sql все становиться намного сложнее.

0

А как бы Вы оценили плюсы и минусы реализации обозначенной в статье задачи на ELK относительно Splunk?

Одному_моему_другуприснилось доводилось делать очень похожее решение как раз на ELK: CDR'ы по SFTP с CUCM грузятся на сервер, разбираются в Logstash и складываются в индексы на Elasticsearch. На Kibana собраны дашборды под возникшие нужды. Большинство визуализаций создается в пару кликов. Дашборды можно генерировать динамически, есть возможность их вставки через iframe в сторонние ресурсы.

Плюс базовый ELK бесплатен без ограничений на объемы информации и количество нод в кластере (в противовес стоимости on-premise железа у Elastic, если мне не изменяет память, есть и SaaS-опции).

Одному_моему_другу

Плюс базовый ELK бесплатен без ограничений на объемы информации и количество нод в кластере (в противовес стоимости on-premise железа у Elastic, если мне не изменяет память, есть и SaaS-опции).

0

Ключевое различие ELK и Splunk в том, что ELK — это open source, а Splunk — это проприетарный продукт. Отсюда растёт ряд следствий и различий и их достаточно много.

Что касается непосредственно этой задачи, то можно сказать следующее: так как в большинстве случаев можно обойтись бесплатной версией Splunk — вопрос о стоимости лицензии не стоит. Остается стоимость внедрения и стоимость обслуживания (наличие специалистов, кто будет работать с системой).

Стоимость внедрения Splunk, даже если мы говорим не про деньги а просто про время, намного ниже. Обучиться базовому функционалу неподготовленному пользователю тоже намного быстрее. Тот функционал, который Вы описываете в ELK, так или иначе доступен, а главное все это находится в одном продукте.

Что касается непосредственно этой задачи, то можно сказать следующее: так как в большинстве случаев можно обойтись бесплатной версией Splunk — вопрос о стоимости лицензии не стоит. Остается стоимость внедрения и стоимость обслуживания (наличие специалистов, кто будет работать с системой).

Стоимость внедрения Splunk, даже если мы говорим не про деньги а просто про время, намного ниже. Обучиться базовому функционалу неподготовленному пользователю тоже намного быстрее. Тот функционал, который Вы описываете в ELK, так или иначе доступен, а главное все это находится в одном продукте.

0

Мы себе в контору делали аналогичный функционал. Но у нас много разных АТСок, помимо астерисков пришлось иметь дело с РТУ, форматом bis+ и т.д. Поэтому поступили следующим образом. Все АТСки скидывают cdr-ы на ftp. Далее наше решение (рабочее название «СКИТ.АТС») забирает логи, по маске названия файла привязывает их к конкретной АТС и парсит. В остальном те же задачи и та же аналитика.

0

Sign up to leave a comment.

Анализ CDR Cisco и Asterisk телефонии с помощью Splunk